Как запустить игру на дискретной видеокарте. Как проверить на какой видеокарте работает игра (на примере NVIDIA)

Вопрос пользователя

Здравствуйте.

У меня на ноутбуке две видеокарты: встроенная Intel HD и дискретная NVIDIA. Почему-то многие игры тормозят (причем, часть из них старые), подозреваю, что они работают на встроенной видеокарте.

Как мне узнать на какой карте они работают, и в случае если не на дискретной, то как ее задействовать? Заранее благодарю.

На самом деле многие современные ноутбуки оснащаются двумя видеокартами: одна встроенная (как правило, Intel HD / Intel Xe Graphics) — используется при работе в Windows, просмотре картинок, видео, не слишком ресурсоемких игр; вторая — дискретная AMD или NVIDIA, необходимая для запуска игр и программ, требующих высокую производительность от видеоадаптера.

По идее разработчиков, дискретная видеокарта должна быть задействована автоматически, когда запускается игра (в остальное время для экономии энергии батареи, должна работать встроенная видеокарта 👀) .

Но происходит подобное не всегда, и часть игр запускается на встроенной — как результат, вы видите тормоза, лаги, задержки и т.д. В этой статье приведу несколько способов, как запускать игры на дискретной видеокарте.

Примечание : в своем мануале ниже я покажу настройку дискретной видеокарты на примере NVIDIA. Если у вас видеокарта от AMD — меню будет несколько отличным, но принцип настройки не изменится (см. на скрины в комментариях 👇).

Способы запуска игры на дискретной видеокарте

👉 Важно!

Прежде чем переходить к способам и тонкой настройке, у вас должны быть установлены актуальные видеодрайвера (по крайней мере, не те, которые устанавливаются по умолчанию с Windows 8/10) . Рекомендую воспользоваться одним из менеджеров по работе с драйверами, для автоматического обновления и установки новых «дров» (ссылки ниже 👇).

1) Обновление драйверов в Windows 10 — обзор 5 лучших программ (на русском) — см. золотую подборку

2) Как обновить драйвер на видеокарту AMD, nVidia и Intel HD: от А до Я — см. инструкцию

Способ №1: с помощью меню настроек видеодрайвера

Если драйвер на видеокарту у вас установлен, то нажав правую кнопку мышки в любом месте рабочего стола, — во всплывшем контекстном меню, Вы должны увидеть ссылку на их настройку (в моем случае это ссылка на «Панель управления NVIDIA» ). Переходим в настройку драйверов дискретной видеокарты.

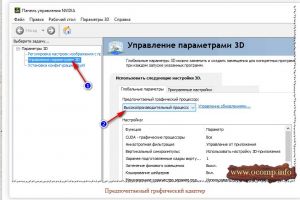

Панель управления NVIDIA // как открыть

Далее в меню слева необходимо выбрать «Управление параметрами 3D» , затем в графе «Предпочитаемый графический адаптер» выбрать «Высокопроизводительный процессор NVIDIA» , затем сохранить настройки. 👇

Предпочитаемый графический адаптер

После этого, можно попробовать запустить игру — должна запуститься на дискретной видеокарте.

Кстати, в настройках NVIDIA так же можно указать для конкретной игры конкретно используемую видеокарту. Для этого нужно сделать следующее:

- открыть настройки видеокарты, затем вкладку «Управление параметрами 3D» ;

- далее открыть вкладку «Программные настройки» ;

- добавить нужную программу (в моем случае добавил игру Цивилизация 4);

- и задать предпочитаемый графический процессор для этого приложения (см. скрин ниже);

- сохранить настройки!

Задание адаптера для конкретной игры

Способ №2: через проводник

Если в настройках NVIDIA задать определенные настройки, то Вы сможете запускать любые игры и программы на нужном вам адаптере в ручном режиме.

Для этого откройте настройки NVIDIA, затем в разделе «Рабочий стол » (меню сверху) поставьте пару галочек:

- Добавить в контекстно меню рабочего стола;

- Добавить пункт «Запустить с графическим процессором» в контекстное меню.

Добавление выбора видеокарты в контекстно меню

Если вы включили предыдущие пару галочек, то самый очевидный и простой способ запустить игру на нужном видеоадаптере — это открыть проводник, то бишь нужную папку, в которой лежит исполняемый файл с игрой, и нажать по файлу игры правой кнопкой мышки (кстати, можно это сделать и по значку на рабочем столе).

Далее в контекстном меню выбрать: «Запустить с графическим процессором —> Высокопроизводительный процессор NVIDIA» . См. скриншот ниже. 👇

Выбор видеоадаптера для запуска игры

Собственно, игра должна запуститься на выбранном вами адаптере. Теперь, ниже, рассмотрю способ, как проверить так ли это.

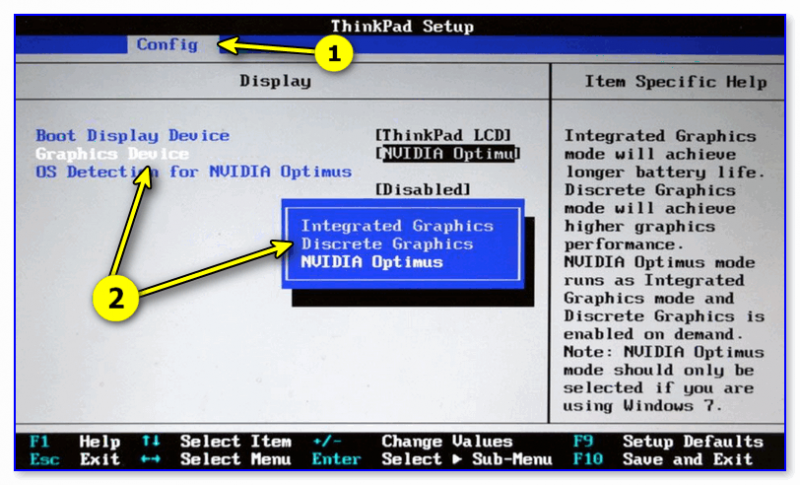

Способ №3: через настройки BIOS

В некоторых ноутбуках через меню настроек BIOS можно указать тот адаптер, который будет работать по умолчанию.

Например, вы можете установить вариант «Discrete Graphics» — и ноутбук будет постоянно использовать дискретную видеокарту (и, само собой, вам не придется вручную каждый раз что-то настраивать через панель видеодрайвера).

- как войти в BIOS — см. инструкцию;

- параметр , который нужно найти: «Graphics Device» / «Graphics Mode» и др. производные ( повторюсь : опция есть не на всех ноутбуках!);

- перевод настроек : «Discrete» — дискретный адаптер; «Integrated» — встроенная видеокарта (как правило, менее производительная); » NVIDIA Optimus / Switchable » — режим, при котором ноутбук автоматически задействует нужную ему видеокарту.

Discrete Graphics — настройки BIOS

Как проверить работает ли игра на дискретной видеокарте

Сначала заходим в настройки видеокарты NVIDIA и открываем меню «Рабочий стол» . В этом меню нужно включить один параметр «Отображать значок активности ГП в области уведомления» . Этот значок позволит видеть, когда загружен адаптер NVIDIA, собственно, то, что мы и ищем. 👇

Включаем значок активности ГП NVIDIA

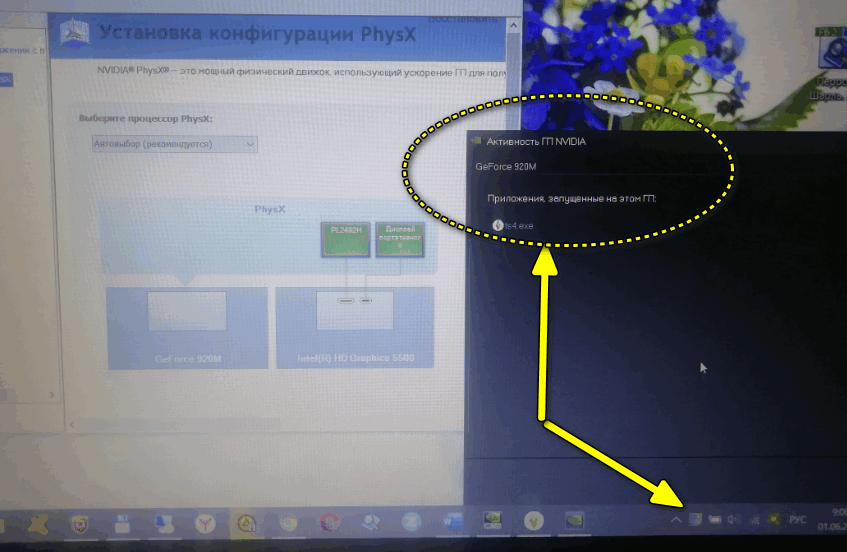

Кстати, обратите внимание, что после включения данной опции, у вас в трее, рядом с часами, появится соответствующий значок (см. скриншот ниже 👇).

Значок активности ГП — рядом с часами

Теперь запускаем игру. Если игра идет в полноэкранном режиме, сверните ее с помощью кнопок WIN или Alt+TAB .

Обратите внимание, что значок с ГП NVIDIA стал цветным (на скрине ниже). Т.е. адаптер NVIDIA начал работать после запуска вашей игры — значит он задействован!

Значок стал цветным после запуска игры (снизу)

Также щелкнув по этому значку можно увидеть, какие игры (приложения) сейчас используют данный адаптер (см. скрин ниже 👇).

Какие приложения используют ГП NVIDIA

В общем-то, этой самый актуальный и надежный способ определения, задействована ли дискретная видеокарта.

С помощью анализа FPS

Так же косвенно определить задействована ли у вас дискретная видеокарта можно по количеству FPS (количеству кадров в игре). У дискретной видеокарты оно, обычно, выше.

Чтобы видеть количество FPS в играх, установите одно из нескольких приложений: Fraps, PlayClaw, Overwolf. Затем запустите преднамеренно какую-нибудь игру на встроенной и дискретной видеокартах, и увидите разницу (см. скрин ниже 👇)!

Программы для просмотра FPS, а также о том, как его повысить, можете узнать в этой статье

В случае необходимости, прибавьте настройки графики на максимальные, чтобы задействовать ресурсы полностью (для более очевидной разницы).

Разница в FPS между дискретной и встроенной видеокартой

И еще одно!

Обратите внимание на шум и температуру работы вашего ноутбука. Если будет задействована дискретная видеокарта, многие модели ноутбуков начинают шуметь заметно выше. Так же начинает расти температура видеоадаптера (ее можно узнать с помощью спец. утилит, например, Speccy, скрин ниже 👇).

Температура процессора и видеокарты // Speccy

Почему игра может не запускаться на дискретной видеокарте

Некоторые игры упорно не хотят запускаться на дискретной видеокарте. В настройках драйвера все задаешь, в ручную указываешь как запустить, а все равно — игра идет на встроенной, лагает и притормаживает. В этом случае, рекомендую несколько вещей (сталкивался сам, неоднократно) !

1. Проверьте настройки BIOS

Возможно, что в BIOS стоит режим принудительного использования только интегрированной графики. Чтобы «снять» этот вопрос — просто 👉 сбросьте настройки BIOS до оптимальных.

2. Попробуйте другую ОС, например, Windows 7

На одном ноутбуке долго никак не мог понять, почему одна старая игра упорно не запускалась на дискретной видеокарте (на нем, кстати, была установлена Windows 10). Потом решил создать еще один раздел на жестком диске и установить вторую ОС — Windows 7. Удивительно, но в Windows 7 игра запустилась без проблем на дискретной видеокарте.

Вывод : Windows 10 некорректно работает с двумя видеокартами (встроенной и дискретной) и старыми играми. Также, возможно, виной тому и драйвера, которые еще до конца не оптимизированы для «новой» Windows 10.

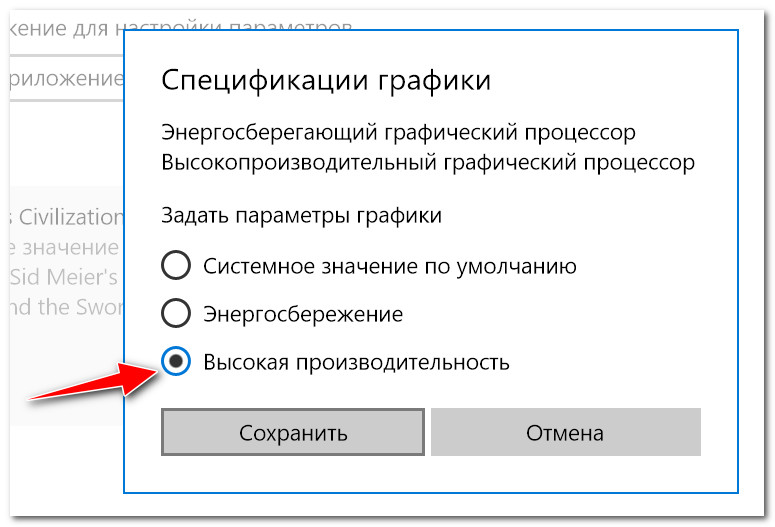

Обновление от 3.08.2018 : в Windows 10 появился параметр, отвечающий за то, как будут работать видеоадаптеры: в энергосберегающем режиме или в высокой производительности. Как это настроить — см. здесь: https://ocomp.info/win10-rejim-perekl-grafiki.html

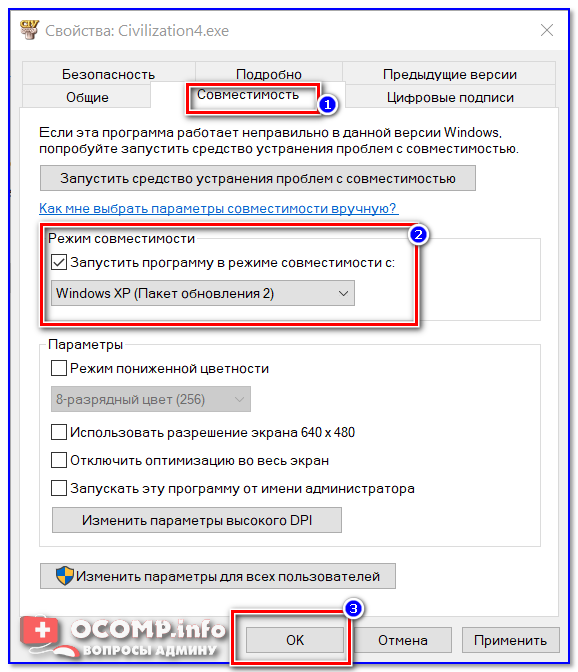

3. Попробуйте включить режим совместимости и отключить масштабирование

Для этого просто откройте свойства нужного EXE-файла. Далее в разделе «Совместимость» поставьте галочку «Запустить программу в режиме совместимости с такой-то Windows» (пример ниже 👇).

Запустить игру в режиме совместимости с Windiows XP SP 2

4. Попробуйте установить более старую версию драйвера (на видеокарту)

Не всегда самый новый драйвер — самый лучший. Возможно, что в новом драйвере происходит какая-то ошибка, и дискретная карта не активируется при запуске игры. Поэтому, и следует попробовать более старую версию драйвера, которая уже была отработана долгими месяцами (годами).

👉 В помощь!

Восстановление старого рабочего драйвера: откат к предыдущей версии — https://ocomp.info/otkat-k-predyidushhey-drayveru.html

На этом у меня всё, надеюсь на первоначальный вопрос ответил развернуто.

Первая публикация: 19.03.2017

А как запустить игру на дискретной видюхе АМД 7600?

Аналогично

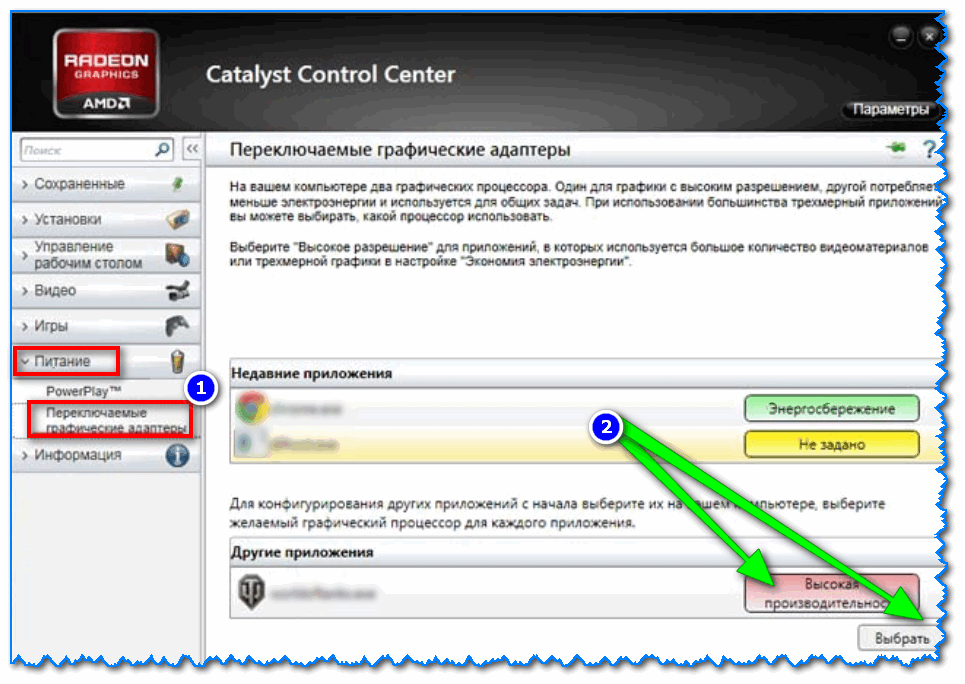

Ниже приведу скрин (в принципе меню аналогично, как и у Nvidia).

Не помогло, Игра Generals Command and Conquer =( Видюха GTX1050

Пробовали другую ОС? Например, вместо Windows 10 — использовать Windows 8, 7?

Почему-то Windows 10 до сих пор коряво работает с встроенным и дискретным адаптерами.

Здравствуйте, у меня нету такой функции выбора графического процесора что делать?

А у вас он есть?

Дэк, я бы поставил 7-рку, но под нее дров нет. На оф сайте только для 10-ой. Тоже не видит дискретки.

В настройках Видяхи вообще ничего нет про выбор.

А вот эту опцию пробовали? https://ocomp.info/win10-rejim-perekl-grafiki.html

rambler737 :

Всем привет! Самый кошмарный случай произошел со мной, думал что на ноутбуке не работает основная видеокарта Geforce 740m, купил новую материнскую плату, но и там тоже не работает основная видеокарта 740m, а работает Intel 4000. Вследствие этого, все игры тормозят, а некоторые вообще не запускаются, при запуске даже GTA 4 ноутбук отключается. Термопаста менялась, ноутбук не запылен. Пробовал задействовать через настройки Nvidia основную видеокарту, толку 0. Ноутбук Acer E1-570g.

Здравствуйте. 1) Я думаю, что драйвера вы все же обновляли и BIOS сбрасывали? (если даже до смены железа дошли). Центр nVidia есть с выбором видеокарты? Если драйвера обновлены — он должен быть! (если его нет — копайте в сторону драйверов).

2) Какая ОС Windows? Если Windows XP — то там просто нет возможности переключать Intel на nVidia в программном варианте.

Также Windows 10 не очень хорошо работает с переключением (особенно старых игр). Если у вас одна из этих ОС — попробуйте Windows 7, скажем.

rambler737 :

У меня Windows 10, я пытался сбросить БИОС — переустанавливал, потом опять переустановил Windows 10. Переустановил все драйвера. Опять 25, игры используют видеокарту Intel 4000, но незадействуется основная видеокарта GeForce 740M, ноутбук при запуске игр GTA4, GTA5, Neeed for Speed, отключается.

Попробуйте все-таки Windows 7/8, дабы можно установить не вредя вашей основной ОС Windows 10 (и насчет драйверов — центр управления-то у вас есть/нет, где можно выбрать видеокарту?)

Спасибо, мне вот это помогло. Скачал Crash Bandicoot N. Sane Trilogy и он работал на встроенной графике, лагало все. После этого поменял в панеле нвида и все ок. Еще раз спасибо

На Windows 10 слабые игры включаются через встроенную видеокарту Intel (но они на ней выдают 20-30 FPS на низких настройках), переключил в утилите от AMD на высокую производительность, но запускается всё равно через Intel. Выключил в диспетчере устройств встроенную видеокарту, но не прокатило, слабые игры запускаются через процессор (там дело, естественно, ещё хуже). Буду пробовать варианты от начала до конца

Возможно, вы выбрали старые игры, с некоторыми из которых Windows 10 работает «не правильно». Я тоже сталкивался с подобной проблемой, кардинально решить вопрос может установка Windows 7 в качестве альтернативной ОС (на ней почему-то все ОК. ).

У меня ноутбук pavilion g6 с двумя видеокартами: встроенная 7660g и дискретная 7600m. Перепробовал все методы, попросту все! Обновил дрова до radeon settings, там тоже ставил всё на высокую производительность, но не чего не помогает. Например, играю в СтарКрафт2, и в настройках пишет, что используется встроенная видеокарта 7660, но играть еще можно (а вот остальные игры лагают, GTA 4 скажем). COD Black ops 1 вообще тормозит, играть невозможно. Помогите пожалуйста. Когда покупал его на нем раньше стоял Windows 7, но мне переустановили на 10 про. Ну реально попросту все перепробовал. Помогите пожалуйста! Буду очень благодарен.

А второй системой Windows 7 не пробовали поставить?

И мои все файлы на 10 винде удалятся, если я откачу систему до 7?

Зачем что-то удалять? Просто для проверки установить вторую ОС, вот тут подробнее (https://ocomp.info/kak-ustanovit-vtoruyu-windows.html)

А если ты не понимаешь, как это сделать? Можно как-то вернуть ноут в прежнее состояние? (без потери данных)

Тогда обратится к тому кто знает, либо отнести устройство в сервис.

У меня вообще дичь: игры идут на дискретной карте, но не все. Танки идут нормально, а вот в некоторых играх — просто черный экран (звук есть).

Добрый день.

Ноутбук acer e5-571g. При подключении внешнего монитора через hdmi кабель — подключается «на Intel» встройку. Не могу найти способа заставить подключиться через дискретку. Если знаете, подскажите, если такой возможности нет, тоже буду рад узнать об этом.

Добрый.

Ноутбук задействует дискретную при запуске «тяжелого» ПО (игр, редакторов и пр.). Мониторить это лучше через спец. значок активности ГП в трее (если нет — в настройках драйвера включите, вкладка «Раб. стол»). Можно ли полностью выкл. интегрированную карту — зависит от самого ноутбука. На большинстве бюджетных такого нет. (т.к. карта Nvidia использует буфер вывода интегр. видеокарты. В общем, монитор подключен к встроенному видео, а nvidia — идет уже за ним, и задействуется в случае необходимости. Т.е. Nvidia выключить можно, а встроенную Intel — нет).

Подскажите, стоит карта GeForce 870M на ноутбуке, и многие игры автоматически запускаются на ней (так как на карте Intel вряд ли бы всё шло. ). Но пробую игру Mount and Blade («пошаговая стратегия») — и никак, идет на Intel. Через управление nVidia уже пробовал — не помогает.

Что можно сделать?

Иногда никак не заставить игру запускаться на дискретной графике (как раз-таки больше всего проблем со старыми играми).

У вас какая ОС? Если 10-ка, есть смысл для игр завести еще одну ОС — Win 7. (на ней «переключение» работает стабильнее).

ОС сейчас стоит 8.1. Для других игр — карта выбирается нормально. Тут тоже выбрать можно, но даже при установке игры в описании железа ПК (что подходит, что нет): стоит карта «Интел Графикс» и мигает красным, мол железо не тянет. И когда при запуске выбираю — не помогает. («Пошаговая стратегия» — я имел ввиду, что игра в неё превращается — начинает тормозить. )

Здравствуйте.

Как на ноуте подключить miniDP к дискретной 1050ti, чтобы та увидела HTC Vive?

Здравствуйте.

Не подскажу.

Здраствуйте.

У меня проблема следующая. На ноутбуке 2 видеокарты дискетная и интегрированная (естественно). Дискетная nvidia geforce gt 650M, а интегрированная intel hd graphics 3000, и у меня за всю историю игр только одна не запускается на дискетной видеокарте — это «тотал вархаммер». Она почему-то запускается только на интегрированной видеокарте. Даже играть в принципе можно со средним фпс в битвах (25), но вот на карте компании (когда долго играешь) — начинаются жуткие фризы и картинка просто дергается. И вот мне бы очень хотелось чтобы эта игра запускалась на нормальной дискетной видеокарте. Я уже чего только не перепробовал, и сделал все так как тут написано — не помогло, и в панели управления все правильно настроил и выставил — тоже ничего (а кстати игра вообще не старая 2016 года). Слышал я, конечно, что эта игра больше затачивалась под видеокарты АМД. Да и, причем, я включил функцию чтобы в области уведомлений показывалось используется ли дискетная видеокарта, и когда запускаю игру смотрю — там показано, что эта игра запустилась якобы на дискетке, но когда в самой игре захожу в настройки — то там отображается только интегрированная. Если кто-нибудь может что-нибудь посоветовать или у кого то был похожий случай и вы его решили — пожалуйста помогите, потому что я уже не знаю, что делать.

Добрый день.

Было такое с Windows 10 и некоторыми играми. После установки Windows 7 — всё норм. стало (держу ее на ноутбуке как запасную на подобные случаи).

Но конкретно с вашей игрой я никогда не сталкивался, и, разумеется, не подскажу. Наверное, вам стоит с этим вопросом обратиться непосредственно на форум этой игры (вероятно, не вы один столкнулись с этим).

Здравствуйте. У меня стоит в ноуте две видюхи: встроенная Intel HD Graphics 4000 и дискретная Nvidia GT 650M. При запуске игры CS:GO высвечивается белый экран в FullHD окне идёт звук и ничего не происходит дальше, то есть висит белый экран и на фоне звук игры. Сворачиваю игру, проверяю в панели управления Nvidiа — там показывает, что игра запущена через дискретную видеокарту, то есть Nvidia. В чем проблема, не могу разобраться. Также у меня проблема возникла с видюхой Intel, а именно при открытии каких-либо 3D приложений которые грузят графику — выскакивает ошибка «Видеодрайвер intel hd graphics drivers for windows 8(r) перестал отвечать» при этом, при входе в браузер со включённым аппаратным ускорением экран был черным и выдавал эту ошибку, а когда отключил аппаратное ускорение в браузере, то она перестала вылазить.

Сделал вывод, что проблема все-таки техническая, в физическом плане все целое и находиться в рабочем состоянии. Помогите пожалуйста!

Как подключить встроенную и дискретную видеокарты для совместной работы

Смысл в том, что видеокарты на ферме работают на пределе возможностей и если использовать компьютер, например, для работы в графическом или видео редакторе, да банально посмотреть фильм не получится нормально, картинка будет «подтормаживать». В тоже время сама видеокарта, которая будет обрабатывать изображение, отбирает часть хешей у майнера, т.е. теряется прибыль.

Оказывается можно включить встроенное видео и использовать его вместе в внешними видеокартами, круто!

Использовать обе видеокарты вместе очень просто, для начала перезагружаем компьютер и заходим в BIOS через кнопку F2 и переходим в Advanced Mode::

Нажимаем на закладочку Advanced:

Читайте также: Не грузится БИОС: поиск неисправности и ее устранение

Далее в меню System Agent (SA) Configuration:

И в раздел Graphics Configuration:

А вот здесь и есть возможность включить интегрированную карту — CPU Graphics:

Теперь сохраняем изменения, выходим из биоса и загружаемся, подключенный через HDMI монитор к встроенной карте уже выдает изображение.

Теперь в диспетчере устройств у нас будет отображена встроенная видео карта:

После активации интегрированного видео у меня возникла ошибка:

Adobe Premiere Pro не удалось найти совместимые видеомодули воспроизведения. Обновите видеодрайверы и запустите приложение повторно.

Эта проблема решается установкой драйверов с сайта производителя.

READ Как подключить usb модем к роутеру zyxel keenetic omni 2

Читайте также: Seagate заявила, что самые быстрые в мире жёсткие диски MACH.2 в производстве оказались дешевле обычных HDD

Данную операцию я проделал на материнской плате ASUS Prime Z270-P

Для чего нужны видеокарты

Если не вдаваться в подробности, видеокарта — устройство обработки графики и формирования видеосигнала на монитор, телевизор или встроенный экран. Играя в игры, просматривая видео, работая в офисных программах или находясь в мессенджере видеоадаптер всегда занят генерацией картинки.

В зависимости от потребностей пользователя в продаже имеются карты различной мощности из разных ценовых сегментов. В 2021 году в этой сфере конкурирует три производителя: AMD, Nvidia и Intel.

Как и любая базовая компьютерная система, видеокарта состоит из собственного процессора (чипа GPU), графической памяти, портов вывода сигнала, подсистемы питания и охлаждения. Это обособленное устройство в большой степени влияет на возможности ПК или ноутбука.

Перед походом в магазин или совершением заказа онлайн нужно узнать, что такое встроенная и дискретная видеокарта в ноутбуке и компьютере.

Интегрированная (встроенная) видеокарта

Встроенной является несъемная из системы видеокарта. Как правило, в современные ноутбуки видеоядро интегрировано в центральный процессор, а видеопамять выделяется из общего количества оперативной (ОЗУ). Популярность интегрированной графики растет и в сегменте персональных компьютеров для офиса и несложных задач.

Преимущества интегрированной графики:

- Низкое тепловыделение улучшит комфорт в использовании системой и снизит требования к качеству охлаждения.

- Малое энергопотребление бережно расходует запас аккумуляторной батареи ноутбука.

- Низкая стоимость как самих устройств, так и отдельных комплектующих со встроенной графикой.

Данный класс видеоускорителей имеет свои недостатки:

- Недостаточная производительность в играх и профессиональных задачах;

- Нет возможности замены интегрированного GPU ноутбуков (с ПК дела проще);

- Техническое отставание от дискретных моделей (не считая новых Intel Xe Graphics).

В отличие от дискретной, интегрированный тип видеокарты определяет назначение ноутбука почти без возможности модернизации. В полноразмерном компьютере можно заменить ЦП с видеоядром на более мощное, или вовсе отказаться от «встройки».

Занимательный факт: в прошлых поколениях систем персональных компьютеров производители зачастую интегрировали видеоядро в материнскую плату наподобие ноутбуков. В наши дни такая схема не применяется ввиду вышеуказанных недостатков и увеличения затрат при производстве.

Дискретная видеокарта (описание, характеристики)

Более разнообразный и универсальный класс. Параметр характеристик «дискретная видеокарта» значит, что это устройство имеет обособленное от ЦПУ видеоядро и собственную, отделенную от ОЗУ, видеопамять. Такая схема актуальная на ноутбуках и ПК в равной степени.

На отдельной плате текстолита распаивают электронные компоненты, и подключают ее к материнской плате посредством разъема интерфейса PCI-E X8-16. В этом принципиальное отличие внешних видеоадаптеров — возможность замены при поломке платы или модернизации.

Преимущества дискреток GPU:

- Высокая производительность в играх, графических редакторах, программах видеомонтажа.

- Вариативность моделей на новом и б/у рынке устройств от конкурентов.

- Возможность замены на более производительное решение.

- Внедрение последних технологий присуще сегменту дискретных устройств.

- Своя система охлаждения и питания на ПК снижает нагрузку на материнскую плату.

Читайте также: Отформатировать флешку через командную строку виндовс

- Высокая цена за счет наличия дополнительной схемотехники.

- Повышенное энергопотребление внешних видеокарт опустошает заряд ноутбука за 2-3 часа интенсивной работы.

- Высокая тепловая нагрузка плохо сказывается на остальных компонентах ноутбука.

- Необходимость установки сложной системы охлаждения.

Если от компьютера требуется запуск объемных игр в разрешении Full HD и выше, декодирование, сложные цифровые вычисления, рендеринг видеороликов, рисование в графических редакторах (типа Corel Draw и Adobe Photoshop), то без внешнего видеоадаптера не обойтись.

У меня ноутбук с двумя видеокартами (встроенная и дискретная). Можно л.

У меня ноутбук с двумя видеокартами (встроенная и дискретная). Можно ли переключаться между ними самостоятельно?

Обычно система делает это сама. Но если очень хочется, то действительно можно.

Первый способ — через BIOS. Чтоб его вызвать, нажмите F2 во время загрузки ОС (работает и на ноутбуках, но не всех). Ну а затем ищите опцию в разделе «Peripherals» или «Config», «Advanced». Зависит от устройства и версии биоса.

Параметры тоже могут быть разными. Где-то достаточно выбрать «Disabled» рядом с названием интегрированной видеокарточки, где-то надо будет перенести нужный чип на верхнюю позицию в списке.

Можно воспользоваться и диспетчером устройств. Это работает, если в настройках отображаются оба адаптера (но не всегда так бывает). Тогда надо просто кликнуть правой кнопкой на ненужный и отключить. Тогда экран отключится, а компьютер надо будет перезагрузить.

Но все же надежнее использовать специальные программы для быстрого и безопасного переключения видеокарт.

К примеру, если дискретная видеокарты от NVidia, то надо на рабочем столе кликнуть правой кнопкой мыши и выбрать пункт «Панель управления NVIDIA». Далее перейти в раздел «Управление параметрами 3D» — «Глобальные параметры».

Теперь там, где написано «Автовыбор», выберите «Высокопроизводительный процессор NVIDIA».

Можно также сделать иначе — в «Панели управления Nvidia» выбрать «Рабочий стол» и поставить галочки на двух последних пунктах («Добавить пункт запустить…», «Отображать значок активности ГП…»). Теперь можно запускать любое приложение с выбранным видеоадаптером, просто открыв контактное меню и выбрав «Запустить с графическим процессором» — «Высокопроизводительный процессор Nvidia».

Если в вашем ноутбуке дополнительная видеокарта от AMD/Radeon, то используйте программу Catalyst. В ней надо выбрать «Переключаемые графические адаптеры» в разделе «Питание». И для каждой программы выбрать видеокарту (точнее, выбор между высокой производительностью и экономией энергии).

Есть еще одна утилита — AMD VISION. В ней для переключения видеокарты надо зайти в раздел «Производительность» — Dual Graphics.

READ Как подключить бук к телеку

Как понять, что дискретная видеокарта поддерживается устройством

Чтобы не разочароваться в возможностях ноутбука советуем подробно ознакомиться с характеристиками его видеоустройства еще до покупки. Если вам не потребуется работать с графикой или играть в топовые AAA-проекты, то будет достаточно моделей с единственным (встроенным) видеоядром.

Процессоры Ryzen 3 4300U и Intel Core i5 10200H снабжены встроенным видеоадаптером

Примером могут стать ноутбуки на процессорах Ryzen 3 4300U или Intel Core i5 10200H, где последние литеры свидетельствуют о графических возможностях и экономичности процессора.

Важно! Если ноутбук оборудован только встройкой с завода, то установить дискретную карту в будущем не получится.

Если дискретная видеокарта указана в спецификациях к ноутбуку это значит, что она заменима в случае неисправности или для увеличения вычислительной мощности. Извлекая ее насовсем, ноут останется работоспособным, используя лишь встройку.

Касательно ПК дела обстоят проще: практически любая материнская плата оборудована слотом PCI-Express для установки внешней видеокарты.

Читайте также: Как самостоятельно поменять разбитый экран на планшете?

Но не все мат.платы поддерживают процессоры со встроенным видеоядром, что можно определить по наличию не ней разъемов VGA, DVI или HDMI на задней стенке моноблока.

Как запустить дискретную или мобильную видеокарту nvidia, amd, intel и другие на ноутбуке и пк

Для начала разберемся с тем, что делать, если случайно отключил видеоадаптер на компе. Сперва необходимо разобрать устройство, отключив его от сети и сняв боковую крышку.

Потом сделать следующее:

Карта должна активироваться автоматически.

На ноутбуках сделать ничего подобного нельзя. Во всех моделях, будь то hp, lenovo, asus или acer, видеоадаптер будет намертво впаян в материнскую плату. Придется довольствоваться комплектацией производителя.

Выбираем дискретную видеокарту

Первое, что нужно сделать перед покупкой дискретной видеокарты — это определиться с задачами, стоящими перед ней.

Вторым по важности фактором выступает цена на устройство, которая в последние год-два взлетела в два раза относительно рекомендуемой. Ну и на третье остается проверка совместимости дискретки с компонентами компьютера (корпус ноута или ПК, блок питания и т.п.).

Важно! Несмотря на наличие универсального разъема PCI-E в ноутбуках среднего и высшего ценового сегмента далеко не все мобильные карты подходят для установки. Есть лишь малый перечень доступных улучшений для конкретной модели, ознакомиться с которым можно на сайте производителя или тематических форумах.

Видеокарта для настольного ПК

Современные офисные машины, на практике, лишены внешнего видеоадаптера из-за ограниченного характера работы. Для обработки массивов данных, набора текстовой информации, просмотра роликов и презентаций в разрешении HD и Full HD, запуска браузера с визуальными эффектами целесообразно установить модель Nvidia GeForce GT 1030 или AMD Radeon RX550.

Nvidia GeForce GT 1030 — оптимальное решение для офисных компьютеров

AMD Radeon RX550 позволит просматривать видео в формате Full HD

Все что выше — выходит за рамки повседневных задач. Все что ниже — находится на уровне встроенной графики.

Геймерам без особых амбиций и с малым бюджетом можно попытать счастье на б/у рынке в поисках выгодного и производительного решения. Иной вариант — купить новый «компромиссный» видеоконтроллер.

Сейчас самым выгодным предложением «с рук» является AMD Radeon RX 570/580 объемом 4 Гб и Nvidia GeForce GTX 1060 на 3 Гб либо их устаревшие аналоги.

В магазине по относительно адекватной цене можно найти Nvidia GeForce GTX 1650 Super 4 Гб, которой достаточно для игры во все современные тайтлы в Full HD на высоких настройках графики.

Желающие играть в разрешении 2К и 4К с ультра-настройками придется раскошелиться на предтоповые решения.

Одним из сбалансированных вариантов в соотношении цена/производительность на момент лета 2021 года является AMD Radeon RX 6700XT с памятью 12 Гб на борту.

AMD Radeon RX 6700XT с памятью 12 Гб

И решение от Nvidia — GeForce RTX 3070 на 10 Гб. Это предельный вариант для массового потребления.

Nvidia GeForce RTX 3070 с 10 Гб памяти

Для тех, кто не ищет компромиссов, и не ограничен в финансах существует две топовых карты AMD Radeon RX 6900XT с 16 Гб и монструозная Nvidia GeForce RTX 3090 с памятью GDDR6X на 24 Гб.

AMD Radeon RX 6900XT с 16 Гб

Nvidia GeForce RTX 3090 с памятью GDDR6X на 24 Гб

Целесообразность покупки такого устройства есть, разве что, в сфере создания 3D-моделей или для монтажа видеоконтента в 4К. Также это выбор геймеров, имеющих 8K монитор с поддержкой HDR и желание играть с технологиями DLSS, Ray Tracing.

Кому точно нужна дискретная видеокарта

Изменчивый дефицит комплектующих на полках магазинов и высокий спрос на карты из-за «криптовалютной лихорадки» вынуждает подавляющее большинство людей довольствоваться только интегрированными решениями.

Такие пользователи рассчитывают на стабилизацию цен и пополнение ассортимента видеокарт в будущем, чтобы купить дискретную графику. Такой подход имеет смысл, учитывая, что свежие решения ЦП+ГПУ не сильно уступают своим собратьям без графических ядер.

Например, целесообразно приобрести 6-ядерный 12-поточный процессор Intel Core i5-10400 или AMD Ryzen 3 4300G на 6 ядер и 8 потоков, дабы пересидеть дефицит, играя в нетребовательные игры (или в современные проекты, но на минимальных настройках). Докупив к нему Nvidia GeForce RTX 3060, со временем пользователь соберет хорошую сборку для Full HD и 2К-гейминга.

Nvidia GeForce RTX 3060

Кому точно не нужна дискретная графика

Внешняя видеокарта может быть лишней по двум причинам:

- Первая — если перед человеком стоят утилитарные офисные задачи, просмотр сериалов и общение в интернете. Для этих целей прекрасно подойдет ноутбук Lenovo IdeaPad 3 на AMD Ryzen 4300U и экраном разрешением 1920×1080 с диагональю 15.6″. Производительности Radeon Vega 5 с лихвой хватит погонять на танчиках и пострелять в CS GO в свободное время, не нуждаясь в дискретке.

- Вторая причина — слабый процессор. Допустим, имеется образцовый офисный системный блок: материнская плата на бюджетном A 320 (A 420) чипсете с процессором AMD Athlon 3000G и низкочастотной памятью DDR4 8 Гб. Покупать низкобюджетную карту (пусть будет Асус Nvidia GeForce GT 1030) в такую сборку будет невыгодным занятием — скорость графических вычислений Vega 3 в ЦПУ не сильно отстает от значений дискретки.

Установив более мощный графический ускоритель, юзер не сможет использовать его возможности в полной мере. В вышеуказанном процессоре всего 2 ядра и 4 потока, что недостаточно для подготовки кадров отрисовки в играх 2021 года. Разумнее оставить систему без дискретного GPU.

Как выбирать и активировать видеокарты в биос

Порой у пользователей возникает необходимость врубить карту системно, после того, как она отключилась и исчезла из поля видимости диспетчера устройств. Сделать это можно при помощи БИОС. Чтобы зайти в него, включите компьютер и нажмите одну из кнопок, высвечивающихся на экране в левом нижнем углу.

После сделайте следующее:

После этого нужно еще раз перезагрузить ПК или ноут, чтобы изменения успели сохраниться.

Если работать в БИОСе вам не нравится, можете скачать одну из программ, эмулирующих системное меню.

Включение дискретной и дополнительной видюхи на компе

Здравствуйте! Современные пользователи, интересующиеся игропромом и работающие в дизайнерских программах, нуждаются в мощном железе. Именно поэтому они покупают видеокарты от nvidia и ставят их на свой ноутбук или компьютер, периодически активируя интегрированный видеоадаптер для простых задач. Сегодня мы расскажем вам, как это сделать, и предоставим несколько подробных инструкций для новичков.

Как запустить дискретную или мобильную видеокарту nvidia, amd, intel и другие на ноутбуке и пк

Для начала разберемся с тем, что делать, если случайно отключил видеоадаптер на компе. Сперва необходимо разобрать устройство, отключив его от сети и сняв боковую крышку.

Читайте также: Как посмотреть какие диски есть на компьютере

Потом сделать следующее:

- Взять видеокарту radeon или любую другую с разъемом PCI-Express или PCI ― в зависимости от того, какой тип подключения поддерживает материнская плата. Эта информация есть в документации.

- Найти на материнской плате длинную полосу контрастного цвета.

- Аккуратно вставить карту промаркированной полосой на одной из сторон в разъем.

- Собрать ПК.

- Запустить его.

Карта должна активироваться автоматически.

На ноутбуках сделать ничего подобного нельзя. Во всех моделях, будь то hp, lenovo, asus или acer, видеоадаптер будет намертво впаян в материнскую плату. Придется довольствоваться комплектацией производителя.

Как выбрать интегрированный видеоадаптер на компьютере и ноуте

Самый простой метод принудительно активировать встроенную видюху ― это достать старую внешнюю из разъема. Не обнаружив видеоадаптера, система автоматически подключит интегрированный.

Есть и такой вариант:

- Перейдите в БИОС.

- Нажмите на Advanced.

- Кликните на System Agent Configuration.

- Перейдите в окно Graphics Configuration.

- Откройте Primary Display.

- Выберите из списка iGPU.

- Сохраните изменения и перезагрузите компьютер.

После этого кликните по панели управления, найдите «Диспетчер устройств» и в меню «адаптеры» активируйте встроенную карту.

Возможно, для нее придется обновить драйвера.

Порой у пользователей возникает необходимость врубить карту системно, после того, как она отключилась и исчезла из поля видимости диспетчера устройств. Сделать это можно при помощи БИОС. Чтобы зайти в него, включите компьютер и нажмите одну из кнопок, высвечивающихся на экране в левом нижнем углу.

После сделайте следующее:

- Нажмите на Chipset.

- Перейдите на Boot Graphic Adapter Priority.

- При помощи стрелочек на клавиатуре выберите из списка нужное устройство (по разъему, к которому оно подключено).

- Нажмите на Enter.

- Сохраните изменения.

После этого нужно еще раз перезагрузить ПК или ноут, чтобы изменения успели сохраниться.

Если работать в БИОСе вам не нравится, можете скачать одну из программ, эмулирующих системное меню.

Как узнать какой видеоадаптер включен сейчас

Самая простая возможность сделать это ― скачать утилиту GPU-Z. Она бесплатна, проста в использовании и не занимает слишком много места на жестком диске. После этого запустите софт и внизу выберите интересующую карту.

Попробуйте запустить игру или какую-то программу, свернитесь и посмотрите на процент загруженности устройства. Если он высок, то работает выбранная видеокарта. Если нет ― все запускается на интегрированной.

Как менять видеокарты, выбирать дополнительную или основную, более мощную

Чтобы в виндовс активировать главный или другой видеоадаптер, необходимо установить утилиту, рекомендованную производителем вашей карты ― ее можно скачать с официального сайта разработчика.

Как узнать какой видеоадаптер включен сейчас

Самая простая возможность сделать это ― скачать утилиту GPU-Z. Она бесплатна, проста в использовании и не занимает слишком много места на жестком диске. После этого запустите софт и внизу выберите интересующую карту.

READ Аудиоблок 6000cd rds как подключить флешку

Попробуйте запустить игру или какую-то программу, свернитесь и посмотрите на процент загруженности устройства. Если он высок, то работает выбранная видеокарта. Если нет ― все запускается на интегрированной.

Как менять видеокарты, выбирать дополнительную или основную, более мощную

Чтобы в виндовс активировать главный или другой видеоадаптер, необходимо установить утилиту, рекомендованную производителем вашей карты ― ее можно скачать с официального сайта разработчика.

Запустите софт, найдите в нем возможность выбрать игровую или слабую карту и активируйте ее. Там же можно обновить драйвера выбранного видеоадаптера и отключить лишнее железо.

NVIDIA Ampere против AMD RDNA 2: битва архитектур

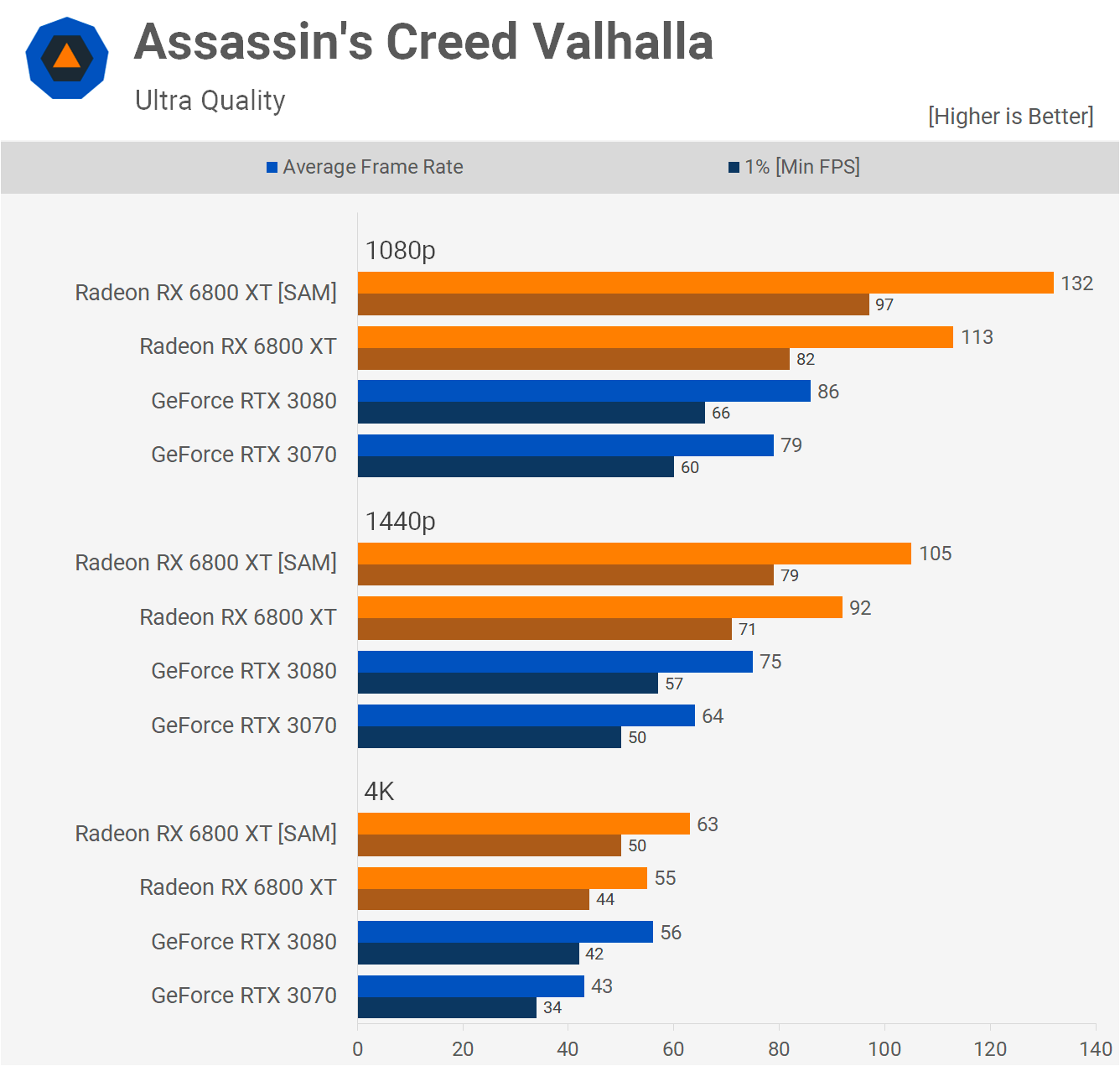

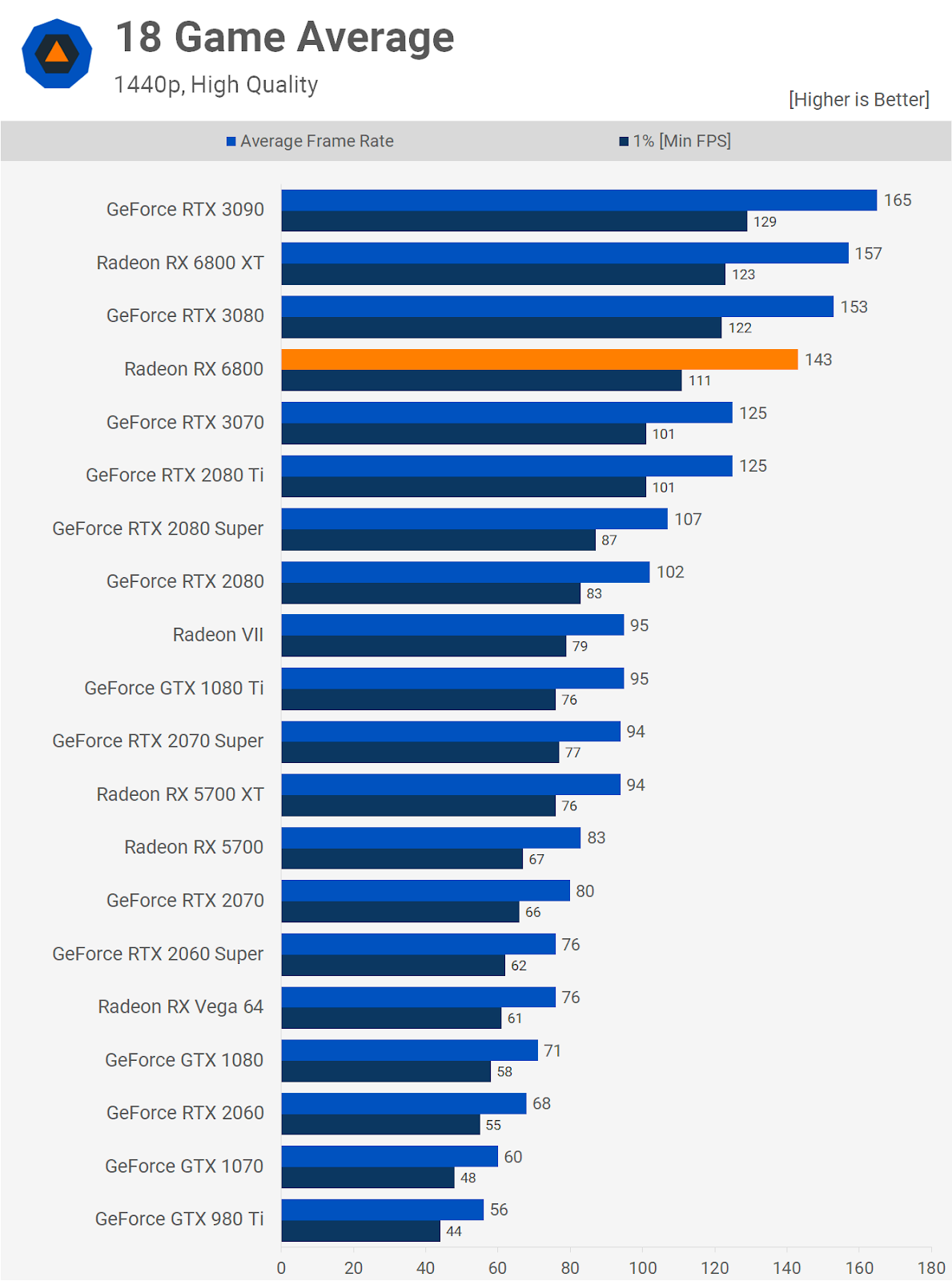

Спустя два года после запуска Turing в сентябре 2020 года NVIDIA сменила архитектуру своих видеокарт на Ampere. AMD не осталась в стороне и вскоре после этого тоже обновила архитектуру RDNA до второй версии.

Всем хотелось, чтобы новые видеокарты RX 6000 могли составить конкуренцию лучшим продуктам NVIDIA. И теперь, когда обе серии вышли в продажу, геймеры оказались избалованы выбором (по крайней мере, теоретически), куда вложить свои деньги.

Но что насчет чипов, лежащих в их основе? Какой из них лучше?

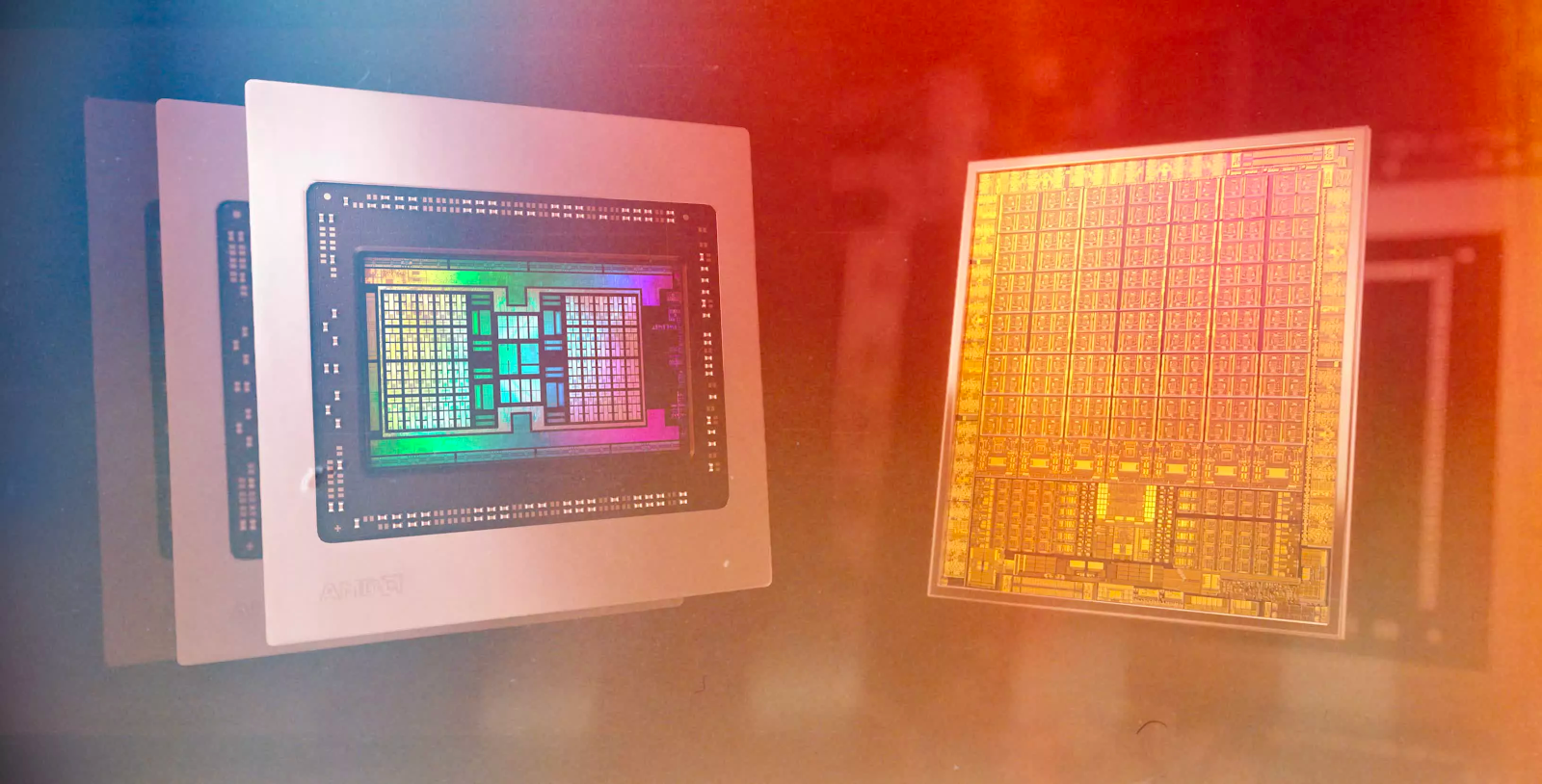

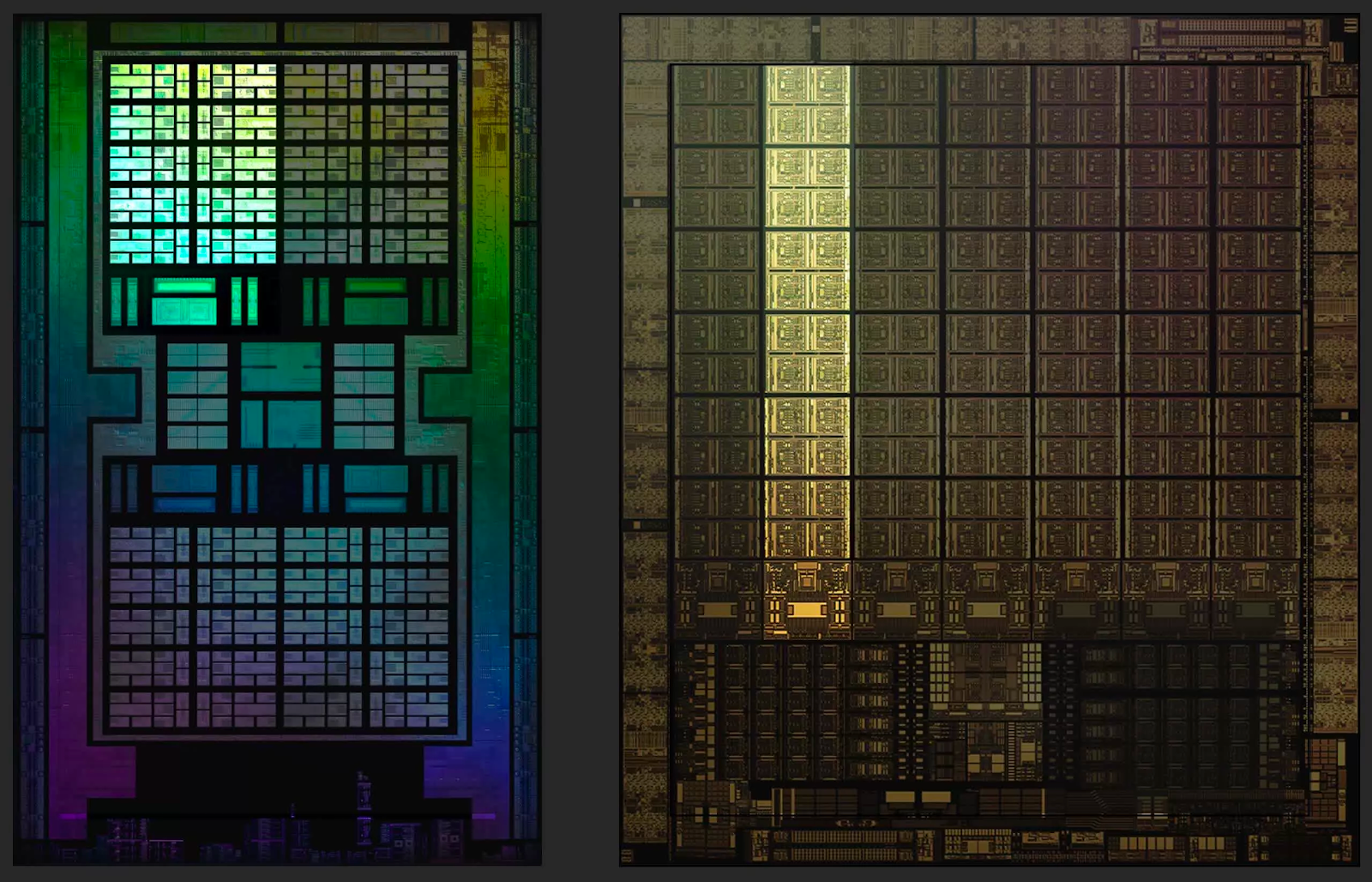

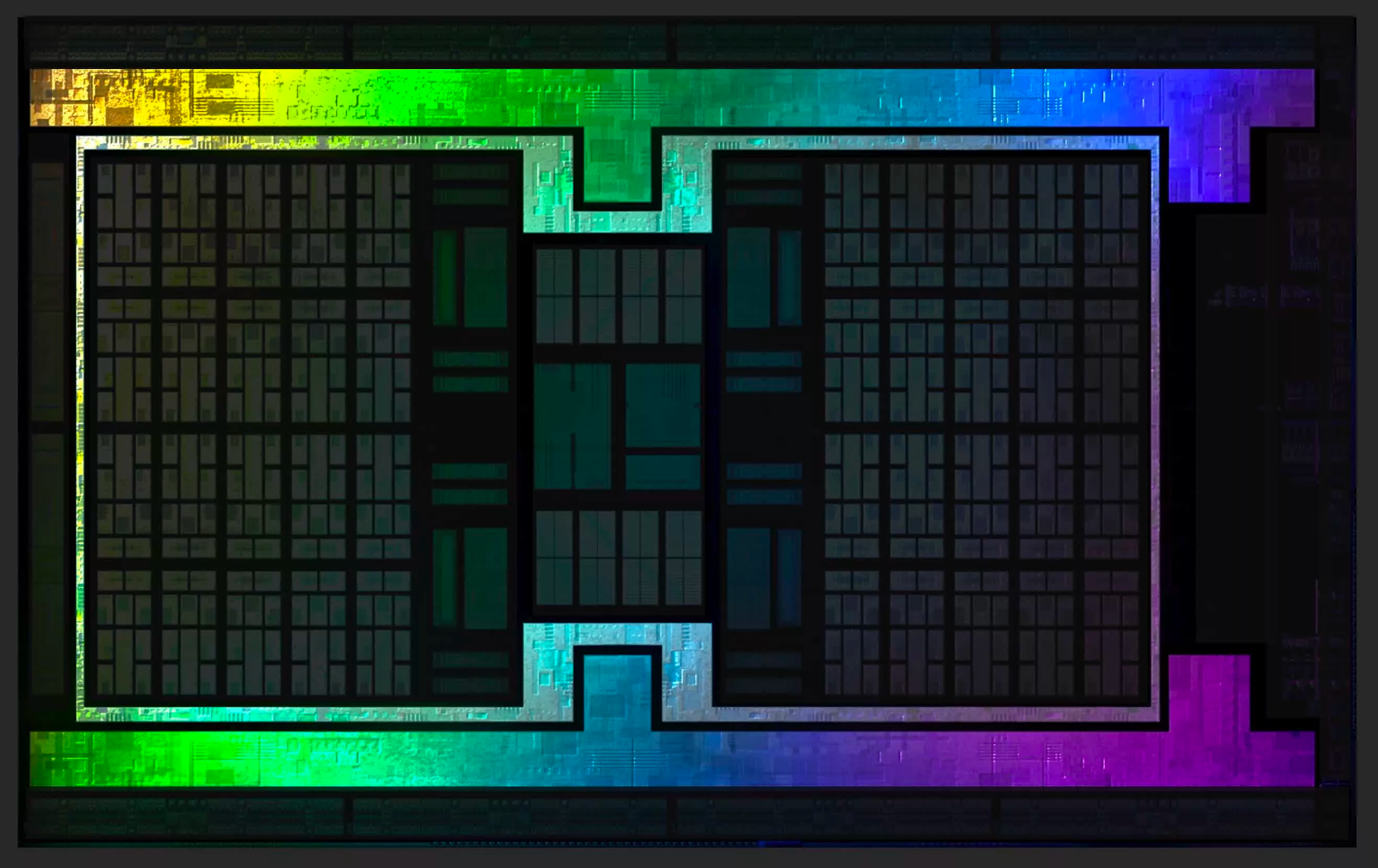

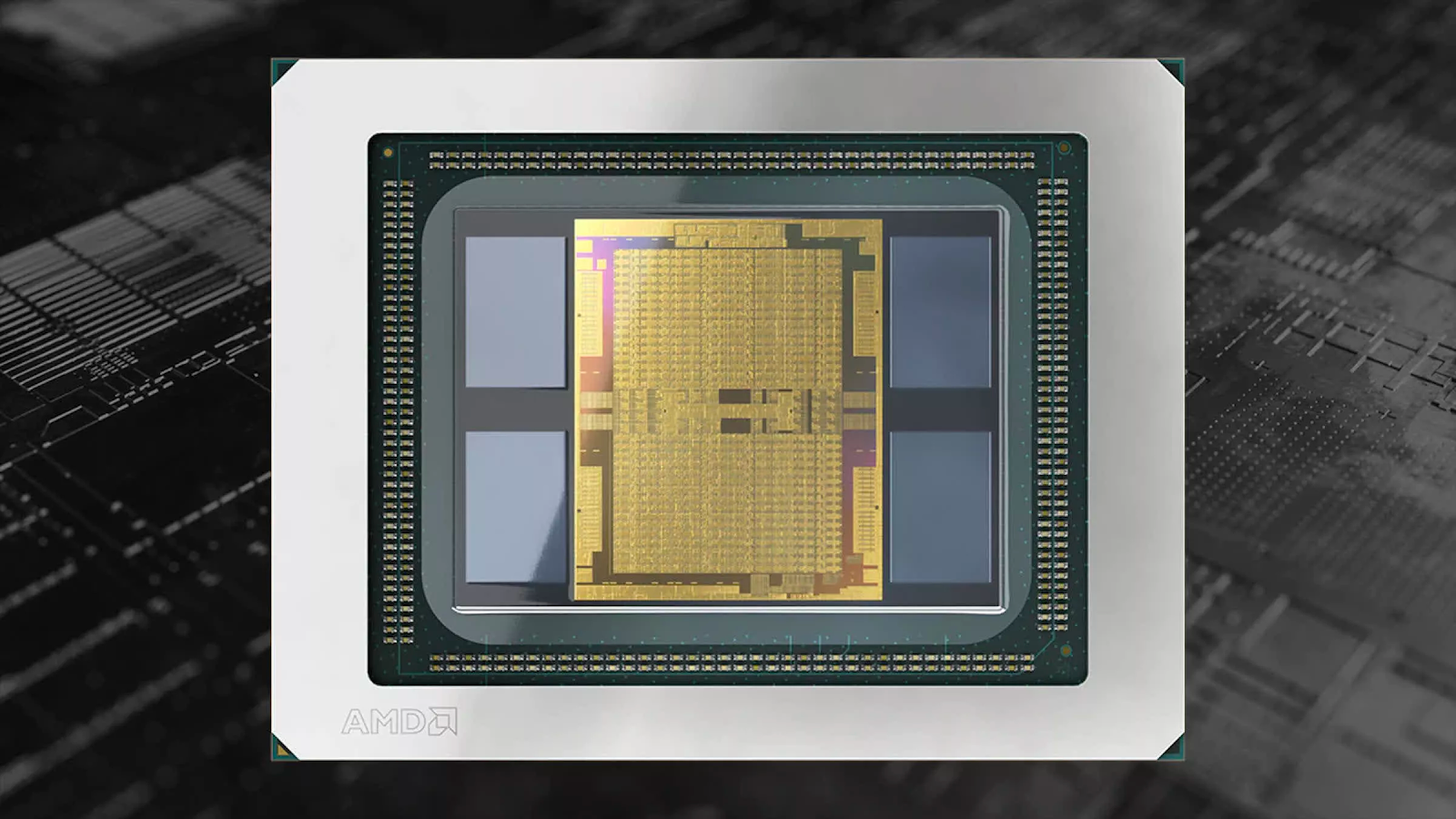

Размеры кристаллов

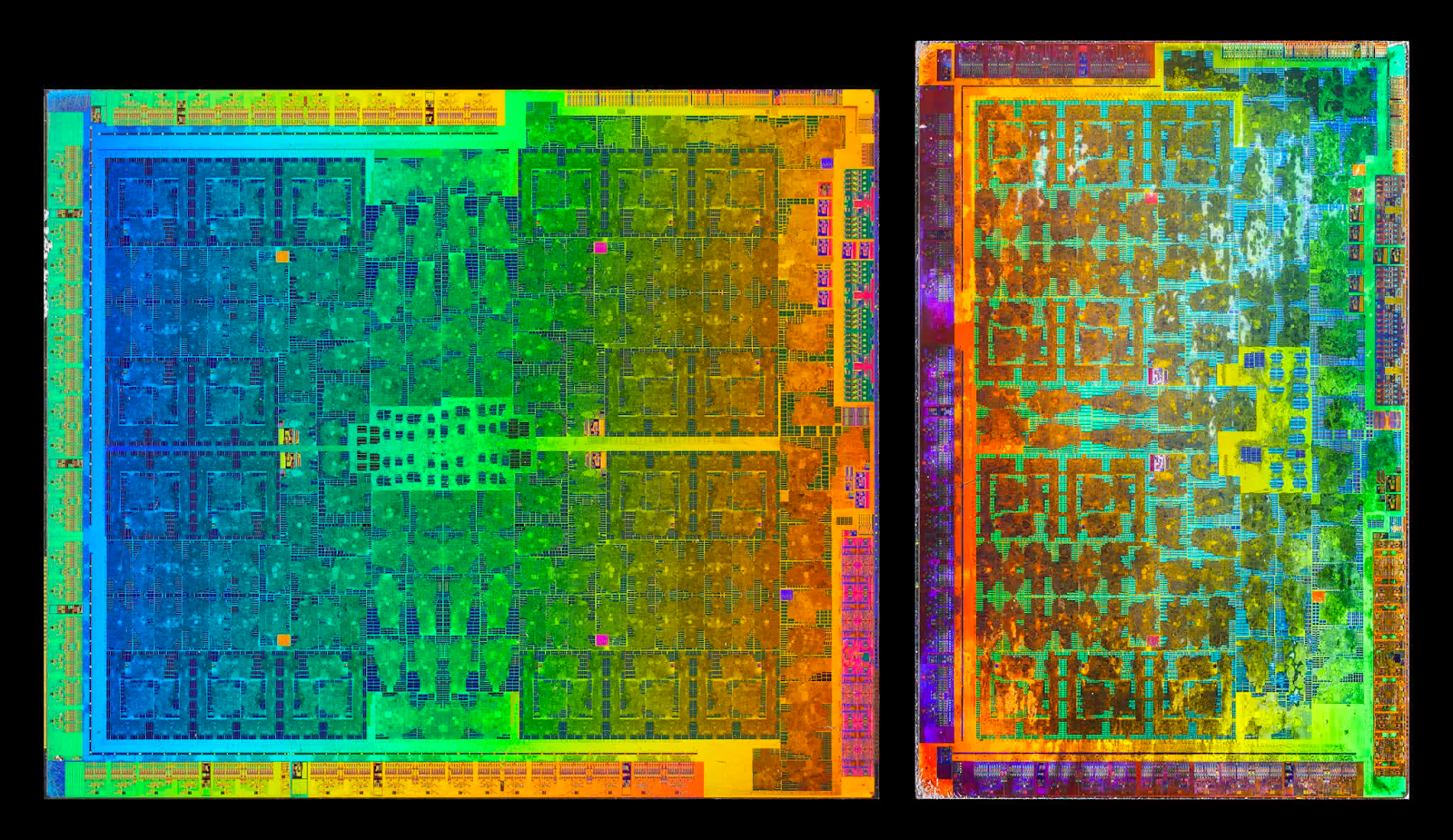

На протяжении долгих лет графические процессоры были больше центральных и продолжают неуклонно расти. Площадь последнего ГП AMD составляет примерно 520 мм2, что более чем в два раза больше их предыдущего чипа Navi. При этом он все еще не самый большой: эта честь принадлежит графическому процессору в новом ускорителе Instinct MI100 с площадью порядка 750 мм 2 .

В последний раз AMD производила игровой процессор размером примерно с Navi 21 для карт Radeon R9 Fury и Nano, которые имели архитектуру GCN 3.0 в чипе Fiji. Его площадь составляла 596 мм 2 .

С 2018 года AMD использует в работе 7-нм процесс от TSMC, и самым большим чипом из этой производственной линейки был Vega 20 (из Radeon VII) с площадью 331 мм 2 . Все графические процессоры Navi созданы на основе слегка обновленной версии этого процесса, называемой N7P.

И все же, что касается размеров кристалла, корона остается за NVIDIA, но не то чтобы это было хорошо. Последний чип на базе Ampere, GA102, имеет площадь 628 мм 2 . Это примерно на 17% меньше, чем у его предка, TU102: он имел ошеломляющую площадь кристалла в 754 мм 2 . Но все это ничто по сравнению с монструозным чипом NVIDIA GA100: используемый в ИИ и обработке данных, этот 7-нм графический процессор имеет площадь 826 мм 2 . Он наглядно показывает, каких размеров может достичь графический процессор.

По сравнению с ГП NVIDIA Navi 21 выглядит довольно стройно, хотя стоит помнить, что процессор — это не только кристалл. GA102 содержит около 28,3 миллиарда транзисторов, тогда как новый чип AMD на 5% меньше — 26,8 миллиарда.

Мы не знаем, из скольких слоев состоит каждый из этих ГП, поэтому все, что мы можем сравнить, — это отношение транзисторов к площади кристалла, обычно называемое плотностью кристалла. Navi 21 имеет примерно 51,5 млн транзисторов на квадратный мм, в GA102 она заметно ниже — 41,1 млн.

Navi 21 производится у TSMC в соответствии с процессом N7P, который дает небольшое увеличение производительности по сравнению с N7. Свои новые чипы GA102 NVIDIA предпочла производить у Samsung. В них используется модифицированная специально для NVIDIA версия так называемого 8-нм узла (обозначаемого как 8N или 8NN). Значения узлов 7 и 8 имеют мало общего с фактическим размером компонентов: это просто маркетинговые термины, используемые для различения производственных технологий.

Теперь давайте углубимся в компоновку каждого графического процессора и посмотрим, что находится у них под капотами.

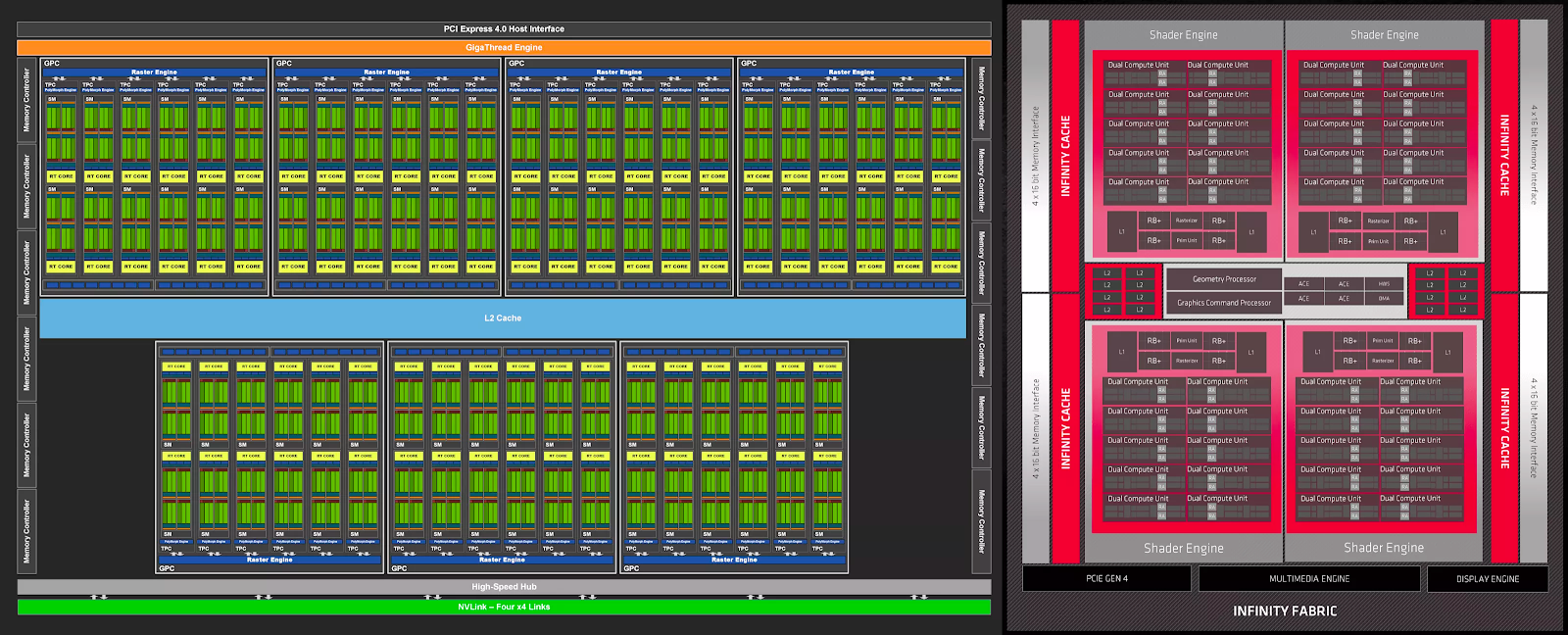

Внутри кристаллов

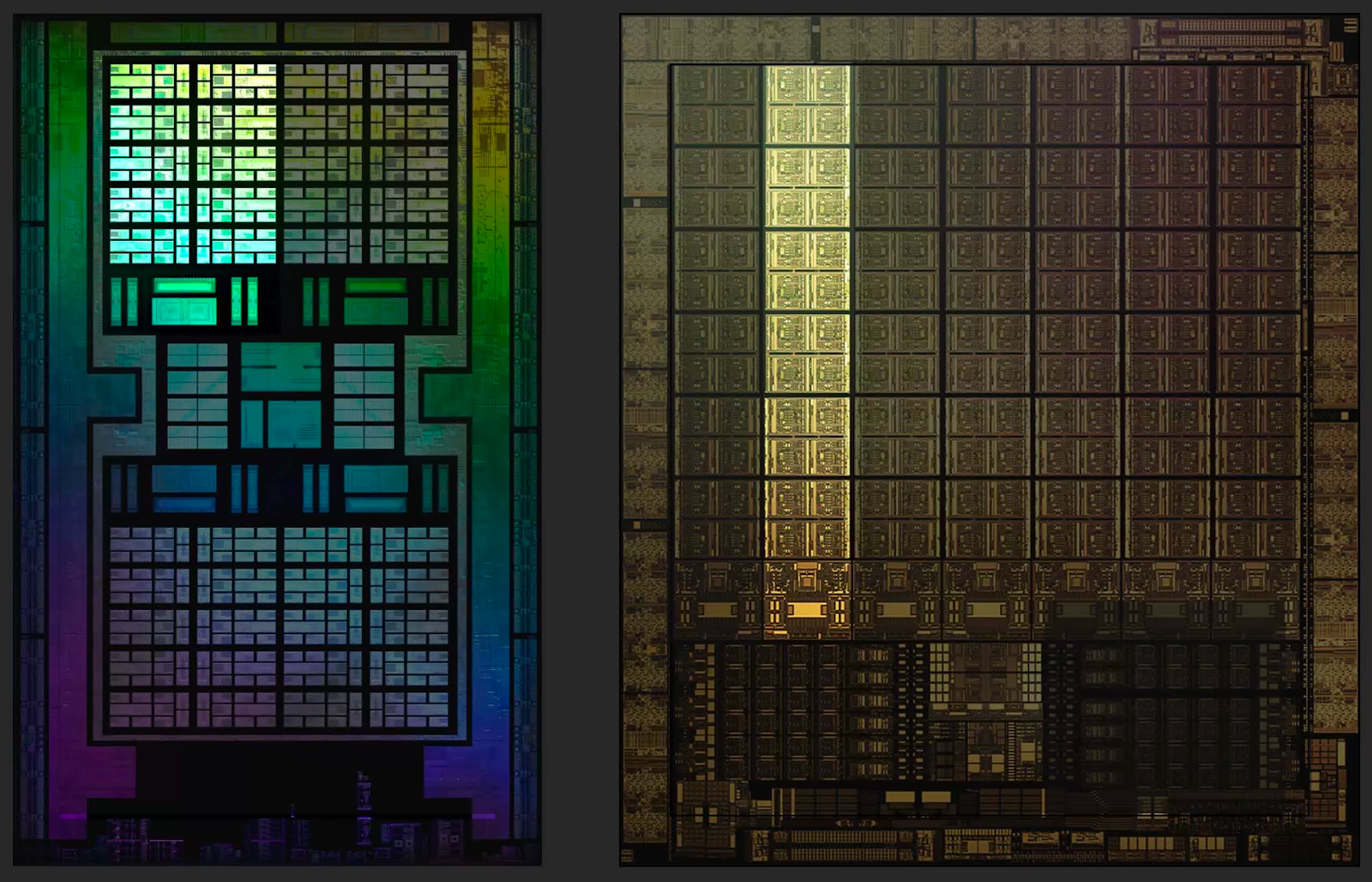

Общая структура Ampere GA102 и RDNA 2 Navi 21

Схемы ниже не обязательно показывают, как все устроено физически, но они дают четкое представление о том, из каких компонентов состоят процессоры.

В обоих случаях макеты очень знакомы, поскольку они по сути являются расширенными версиями своих предшественников. Добавление большего количества компонентов повышает производительность, что особенно полезно при условии, что при высоких разрешениях в современных 3D-приложениях рабочие нагрузки рендеринга включают огромное число параллельных вычислений.

Такие схемы полезны, но для нашего анализа интереснее посмотреть, где находятся различные компоненты внутри самих кристаллов. При проектировании крупномасштабного процессора обычно требуется, чтобы общие ресурсы, такие как контроллеры и кэш, находились в центре, чтобы гарантировать, что все компоненты имеют одинаковый путь к ним.

Интерфейсные системы вроде контроллеров локальной памяти или видеовыходов должны располагаться по краям микросхемы, чтобы упростить их подключение к тысячам отдельных проводов, соединяющих графический процессор с остальной частью карты.

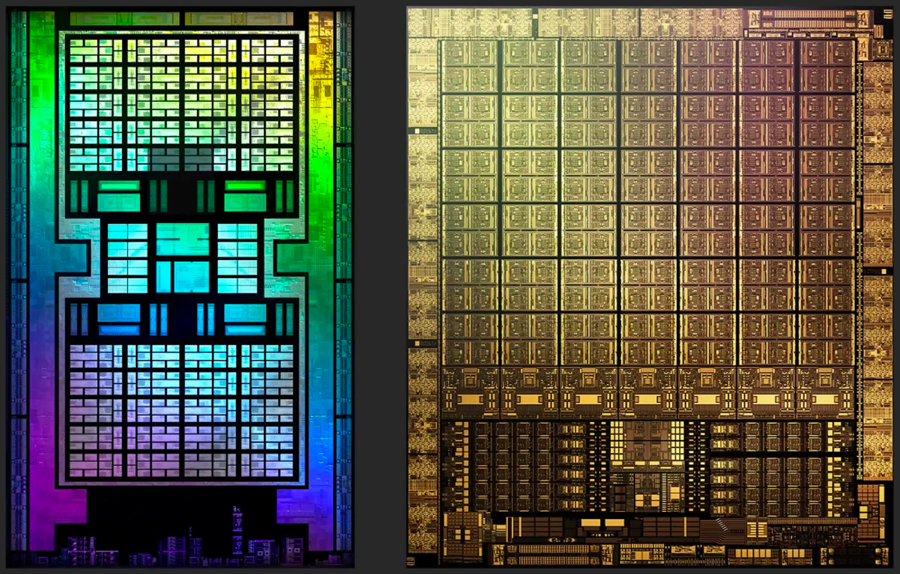

Ниже приведены изображения кристаллов AMD Navi 21 и NVIDIA GA102 в искусственных цветах. Оба изображения были подчищены и показывают только один слой внутри чипа, однако при этом дают хорошее представление о внутренностях современного графического процессора

Наиболее очевидное различие между конструкциями заключается в том, что NVIDIA не следует централизованному подходу к компоновке микросхем: все системные контроллеры и основной кэш находятся внизу, а логические блоки расположены в длинных столбцах. Они проделывали это и раньше, но только с моделями среднего и нижнего ценового сегмента.

Например, Pascal GP106 (используемый в GeForce GTX 1060) был буквально вдвое меньше GP104 (из GeForce GTX 1070). В более ранней версии размер кристалла был больше, а кэш-память и контроллер располагались посередине. У младшего брата они переместились в сторону.

Для всех предыдущих топовых ГП NVIDIA использовала классическую централизованную компоновку. Зачем же было менять подход? Интерфейсы здесь ни при чем, ведь контроллеры памяти и PCI Express работают на краю кристалла. С тепловыми проблемами это тоже не связано, ведь даже если кэш-часть или контроллер кристалла будут нагреваться сильнее, чем логические секции, вам наверняка захочется, чтобы посередине схемы было больше теплопоглощающего кремния. Хотя причина этого изменения не вполне понятна, есть подозрение, что она связана с реализацией блоков вывода рендеринга (ROP).

Позже мы рассмотрим их более подробно, а пока просто скажем, что, хотя изменение макета выглядит странно, оно не оказывает существенного влияния на производительность. Это связано с тем, что 3D-рендеринг сопровождается большим количеством длительных задержек — как правило, из-за необходимости ожидания данных. Таким образом, дополнительные наносекунды, добавленные за счет того, что некоторые логические блоки находятся дальше от кэша, скрываются в общей схеме чипа.

Прежде чем мы продолжим, стоит отметить инженерные изменения, реализованные AMD в компоновке Navi 21 по сравнению с Navi 10, установленном в Radeon RX 5700 XT. Несмотря на то, что новый чип в два раза больше предыдущего как по площади, так и по количеству транзисторов, разработчикам удалось улучшить тактовые частоты без значительного увеличения энергопотребления. Например, Radeon RX 6800 XT имеет базовую частоту и частоту разгона 1825 и 2250 МГц, соответственно, при TDP, равном 300 Вт. Те же показатели для Radeon RX 5700 XT: 1605 МГц, 1905 МГц и 225 Вт.

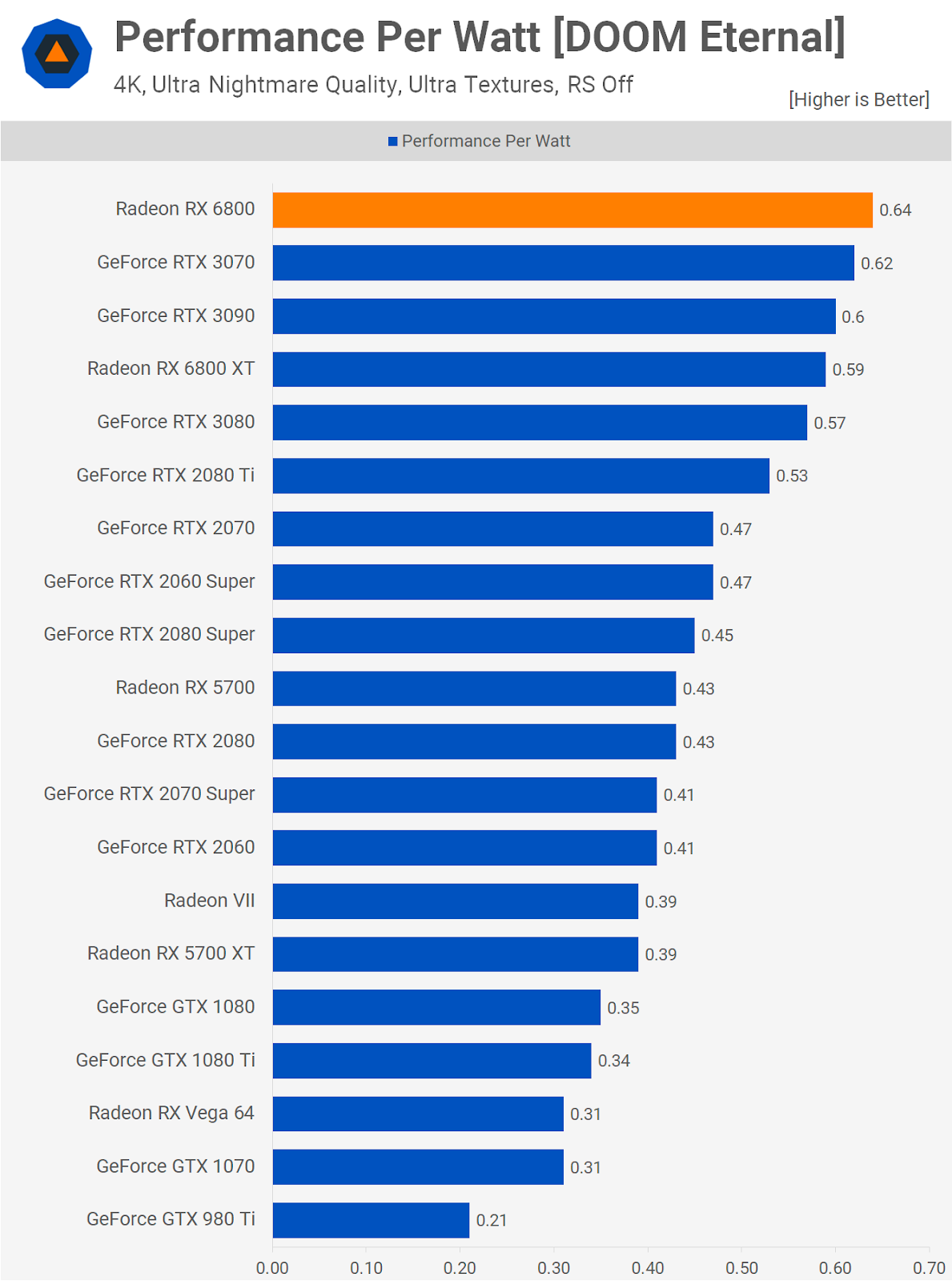

Исследование производительности на ватт карт Ampere и RDNA 2 показало, что оба производителя добились значительных улучшений в этой области, но AMD и TSMC достигли чего-то весьма примечательного — сравните разницу между Radeon RX 6800 и Radeon VII на графике выше.

Radeon VII — первая коллаборация AMD и TSMC с использованием 7-нм технологии, и менее чем за два года они увеличили производительность на ватт на 64%. Отсюда возникает вопрос: насколько лучше мог бы быть Ampere GA102, если бы NVIDIA осталась с TSMC.

Управление ГП

Как все устроено внутри чипов

Драйверы, которые AMD и NVIDIA создают для своих чипов, по сути работают как трансляторы: они преобразуют процедуры, выданные через API, в последовательность операций, понятную графическим процессорам. Затем все зависит от аппаратного обеспечения: какие инструкции выполняются в первую очередь, какая часть микросхемы их выполняет и так далее.

Этот начальный этап управления инструкциями обрабатывается набором модулей в микросхеме. В RDNA 2 графические и вычислительные шейдеры маршрутизируются через отдельные конвейеры, которые планируют и отправляют инструкции остальной части микросхемы: первый называется Graphics Command Processor, второй — асинхронными вычислительными блоками (ACE).

Графические процессоры достигают высокой производительности за счет параллельного выполнения задач, поэтому следующий уровень организации дублируется в чипе. Если проводить аналогию с реальным заводом, это будет похоже на компанию с центральным офисом в одном месте, но производством в нескольких других местах.

AMD называет это Shader Engine (SE), тогда как в NVIDIA они имеют название графических кластеров (GPC): названия разные, но суть одна.

Причина такого разделения проста: блоки обработки графики просто не могут справиться со всем и сразу. Так что имеет смысл продвинуть некоторые обязанности по планированию и организации дальше. Это также означает, что каждый блок может делать что-то независимо от других: скажем, один — обрабатывать графические, другой — вычислительные шейдеры.

В случае RDNA 2 каждый SE содержит собственный набор фиксированных функциональных блоков — схем, предназначенных для выполнения одной конкретной задачи:

- Блок Primitive Setup — подготавливает вершины к обработке, а также генерирует больше вершин (тесселяция) и отбраковывает их;

- Растеризатор — преобразует трехмерный мир треугольников в двухмерную сетку пикселей;

- Блоки вывода рендеринга (ROP) — считывают, записывают и смешивают пиксели.

Блок Primitive Setup работает с частотой 1 треугольник за такт. Параметр может показаться не очень большим, но не забывайте, что эти чипы работают на частотах между 1,8 и 2,2 ГГц, и эта настройка не должна оказываться узким местом ГП. Для Ampere этот блок находится на следующем уровне организации, и об этом мы еще поговорим позже.

Ни AMD, ни NVIDIA не особенно распространяются о своих растеризаторах. NVIDIA называют их Raster Engines. Мы знаем, что они обрабатывают 1 треугольник за такт, но больше никакой информации о них нет — например, о субпиксельной точности.

Каждый SE в чипе Navi 21 содержит 128 ROP; GA102 от NVIDIA включает в себя 112 ROP. Может показаться, что у AMD здесь есть преимущество, ведь большее количество ROP означает, что за такт может обрабатываться больше пикселей. Но такие устройства нуждаются в хорошем доступе к кэш-памяти и локальной памяти, и мы поговорим об этом позже в этой статье. А пока давайте дальше рассмотрим на разделение SE/GPC.

Shader Engines AMD разделены на то, что они сами называют двойными вычислительными блоками (DCU), при этом чип Navi 21 использует десять DCU для каждого SE — обратите внимание, что в некоторых документах они также классифицируются как Workgroup Processors (WGP). В случае Ampere и GA102 они называются кластерами обработки текстур (TPC), причем каждый графический процессор содержит 6 TPC. Они также работают со скоростью 1 треугольник за такт, и хотя графические процессоры NVIDIA работают на меньшей частоте, чем AMD, и у них намного больше TPC, чем у Navi 21 — SE. Таким образом, при той же тактовой частоте GA102 имеет здесь заметное преимущество, поскольку весь чип содержит 42 блока Primitive Setup, тогда как новый RDNA 2 от AMD — только 4. Но поскольку на один Raster Engine приходится шесть TPC, GA102 фактически имеет 7 систем примитивов, в то время как Navi 21 — четыре. Кажется, что NVIDIA имеет здесь явное лидерство.

Последний уровень организации чипов — вычислительные блоки (CU) в RDNA 2 и потоковые мультипроцессоры (SM) в Ampere — производственные линии в наших ГП-«заводах».

В значительной степени они составляют основную начинку ГП, поскольку содержат все программируемые блоки, используемые для обработки графики, вычислений, а теперь еще и трассировки лучей. На изображении выше видно, что каждый из них занимает очень небольшую часть общего пространства кристалла, но они по-прежнему чрезвычайно сложны и очень важны для общей производительности чипа.

Итак, номенклатура у чипов разная, но функции во многом схожи. И поскольку многое из того, что они делают, ограничивается программируемостью и гибкостью, любые преимущества одного из них по сравнению с другим сводятся к простому ощущению масштаба.

Но в случае с CU и SM AMD и NVIDIA используют разные подходы к обработке шейдеров. И пусть в некоторых областях у них много общего, но много и различий.

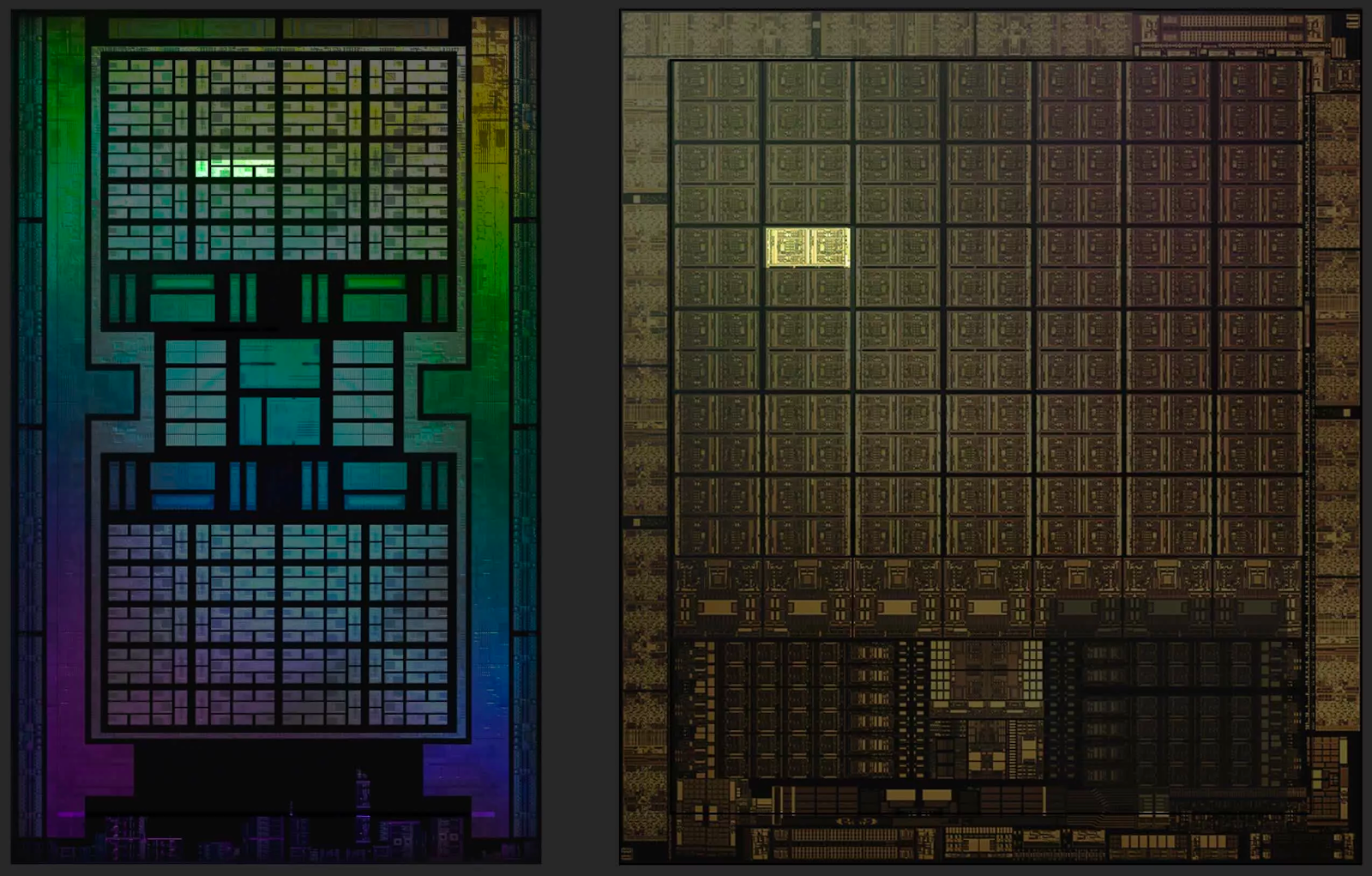

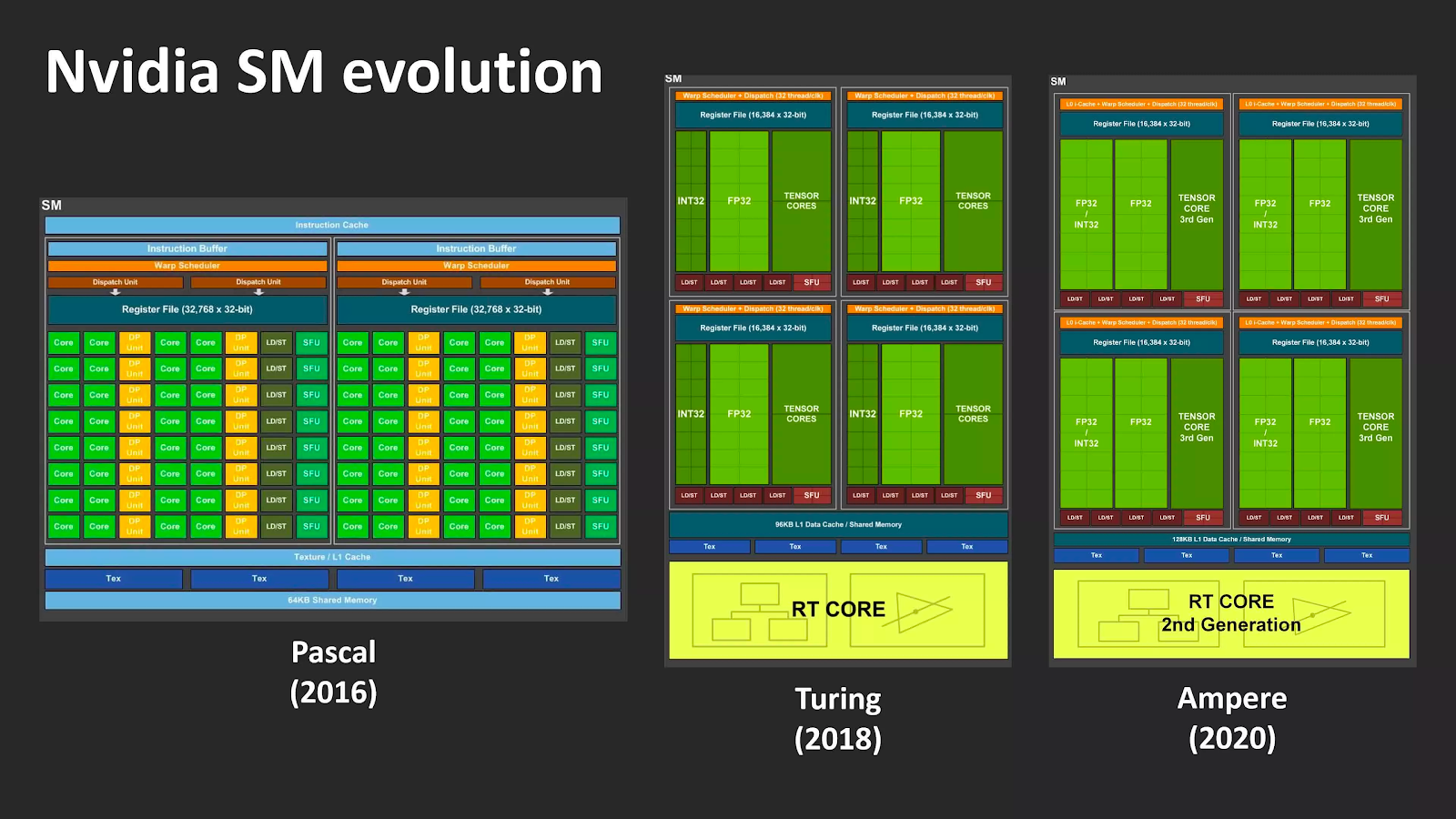

Подсчет ядер по методу NVIDIA

Если Turing имела множество существенных отличий от Pascal, то Ampere кажется довольно мягким обновлением предыдущей архитектуры — по крайней мере, на первый взгляд. Впрочем, мы точно знаем, что по сравнению с Turing новая архитектура имеет более чем в два раза большее количество ядер CUDA в каждом SM.

В Turing потоковые мультипроцессоры содержат четыре раздела (иногда называемых блоками обработки), каждый из которых содержит логические блоки 16x INT32 и 16x FP32. Эти схемы предназначены для выполнения очень специфических математических операций с 32-битными значениями данных: блоки INT обрабатывают целые числа, а FP — числа с плавающей запятой.

NVIDIA заявляет, что SM Ampere имеет в общей сложности 128 ядер CUDA, но, строго говоря, это неправда — или с таким же успехом можно считать, что у Turing их было столько же. Блоки INT32 действительно могли обрабатывать значения с плавающей запятой, но только в очень небольшом количестве простых операций. Для Ampere NVIDIA увеличила поддерживаемый диапазон математических операций с плавающей запятой, чтобы соответствовать другим модулям FP32. Это означает, что общее количество ядер CUDA на SM действительно не изменилось, просто половина из них теперь имеет больше возможностей.

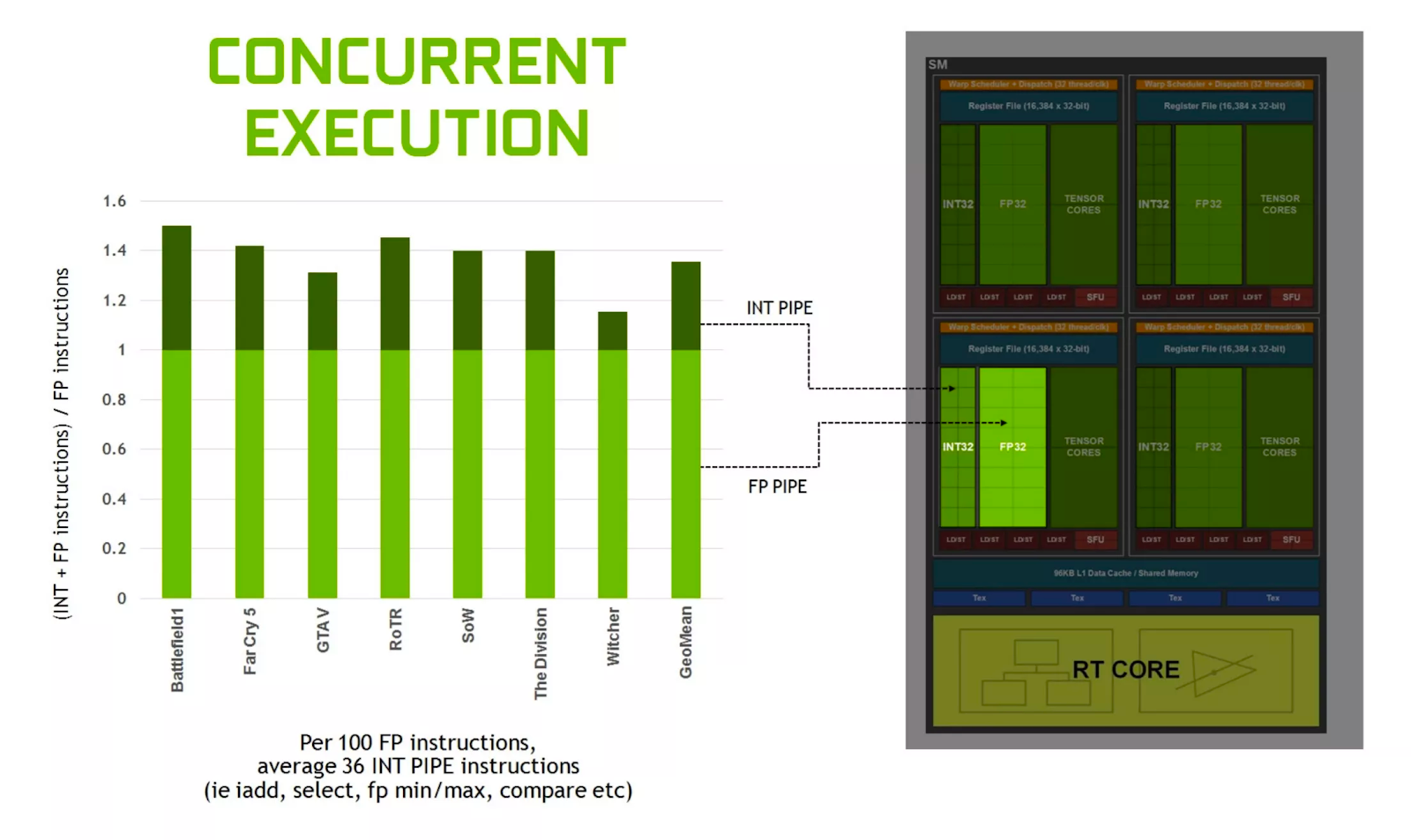

Поскольку блоки INT/FP могут работать независимо, SM Ampere может обрабатывать до 128 вычислений FP32 за цикл или 64 операций FP32 и 64 операций INT32 одновременно. Turing же умела делать только последнее.

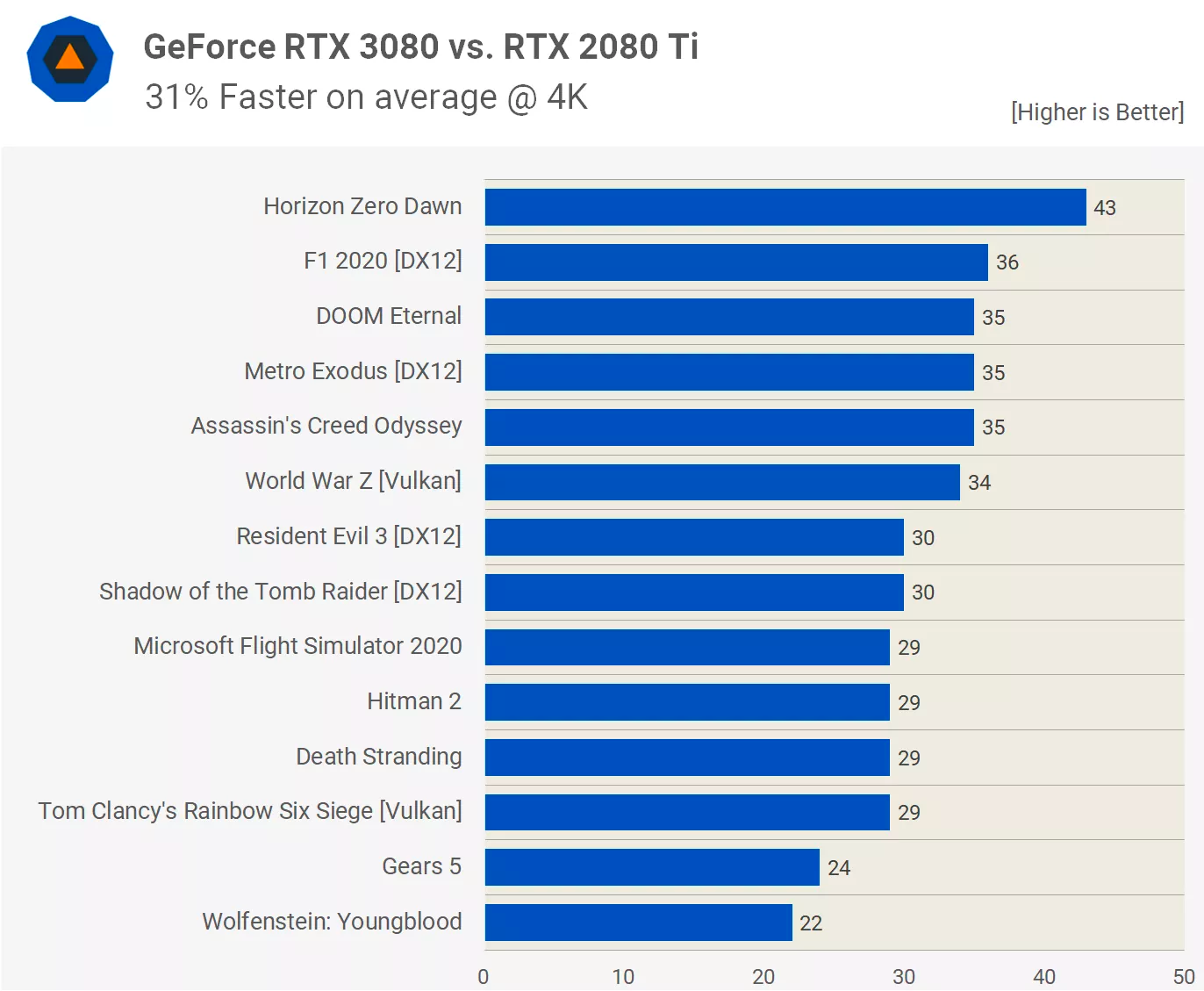

Таким образом, новый графический процессор может потенциально вдвое увеличить производительность FP32 по сравнению с предшественником. Для вычислительных рабочих нагрузок это большой шаг вперед, но для игр польза окажется гораздо меньшей. Это стало очевидно после тестирования GeForce RTX 3080, в которой используется чип GA102 с 68 включенными SM.

Несмотря на то, что пиковая пропускная способность FP32 составляет 121% по сравнению с GeForce 2080 Ti, в среднем она увеличивает частоту кадров только на 31%. Так почему же вся эта вычислительная мощность тратится зря?

Простой ответ: зря она не тратится, просто игры не всегда запускают инструкции FP32.

Когда NVIDIA выпустила Turing в 2018 году, компания отметила, что в среднем около 36% инструкций, обрабатываемых графическим процессором, связаны с процедурами INT32. Эти вычисления обычно выполняются для определения адресов памяти, сравнения двух значений и логического управления.

Таким образом, для этих операций функция двойной скорости FP32 не используется, поскольку блоки с двумя путями данных могут работать только с целыми числами или с плавающей запятой. SM переключится в этот режим только в том случае, если все выстроенные в очередь 32 потока, обрабатываемые им в данный момент, выполняют одну и ту же операцию FP32. Во всех остальных случаях SM в Ampere работают так же, как и в Turing.

Это означает, что GeForce RTX 3080 имеет только 11-процентное преимущество FP32 над 2080 Ti при работе в режиме INT+FP. Вот почему реальный прирост производительности в играх не так высок, как предполагают исходные данные.

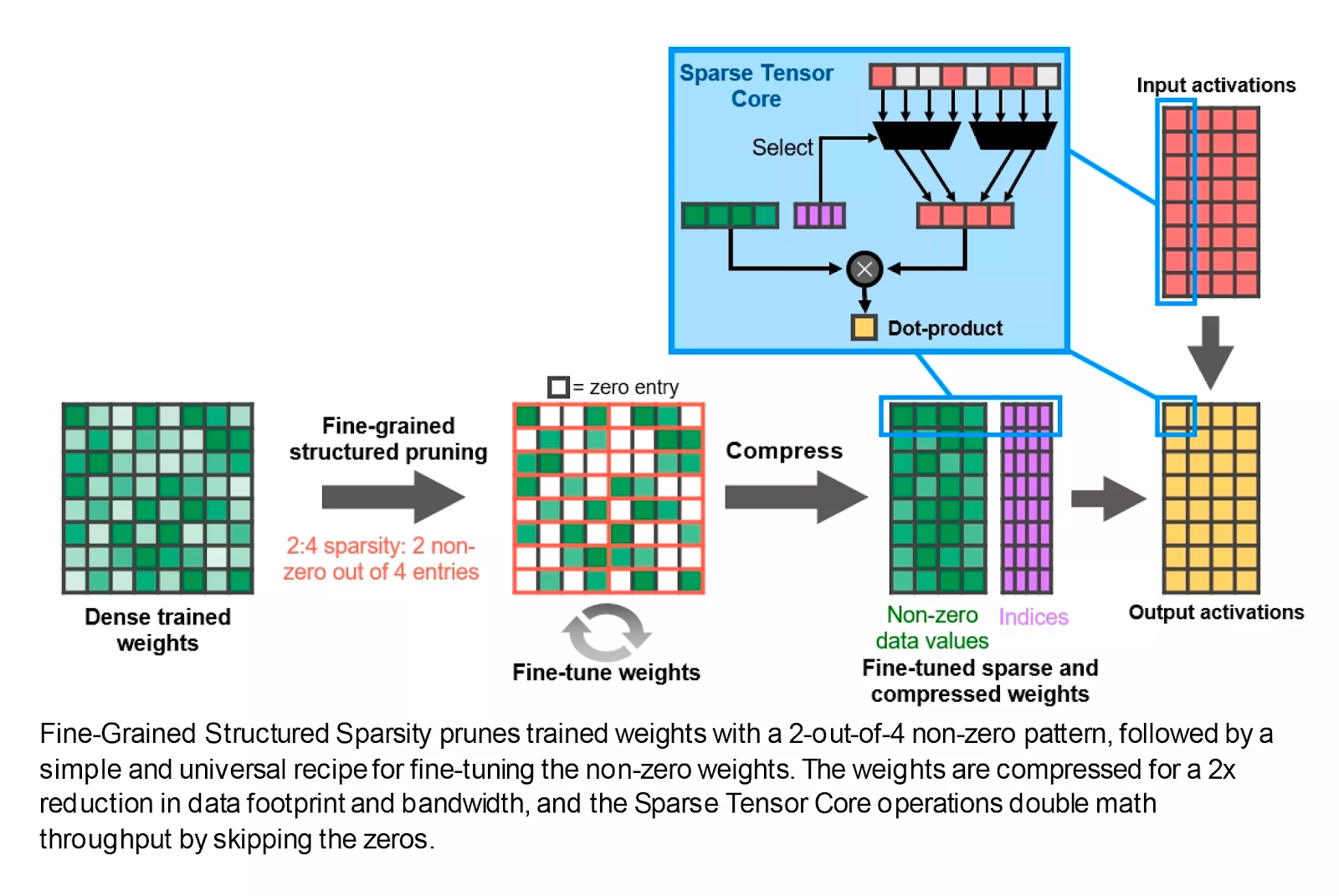

Какие тут еще улучшения? На каждый SM приходится меньше тензорных ядер, но каждое из них оказывается намного более мощным, чем в Turing. Эти схемы выполняют очень специфические вычисления (например, умножают два значения FP16 и складывают ответ с другим FP16), и теперь каждое ядро выполняет 32 таких операции за цикл.

Также есть поддержка новой функции Fine-Grained Structured Sparsity. Если кратко, то с ее помощью математическая скорость может быть удвоена путем удаления данных, которые не влияют на ответ. Опять же, это хорошая новость для профессионалов, работающих с нейронными сетями и искусственным интеллектом, но на данный момент в этом нет никаких значительных преимуществ для игровых разработчиков.

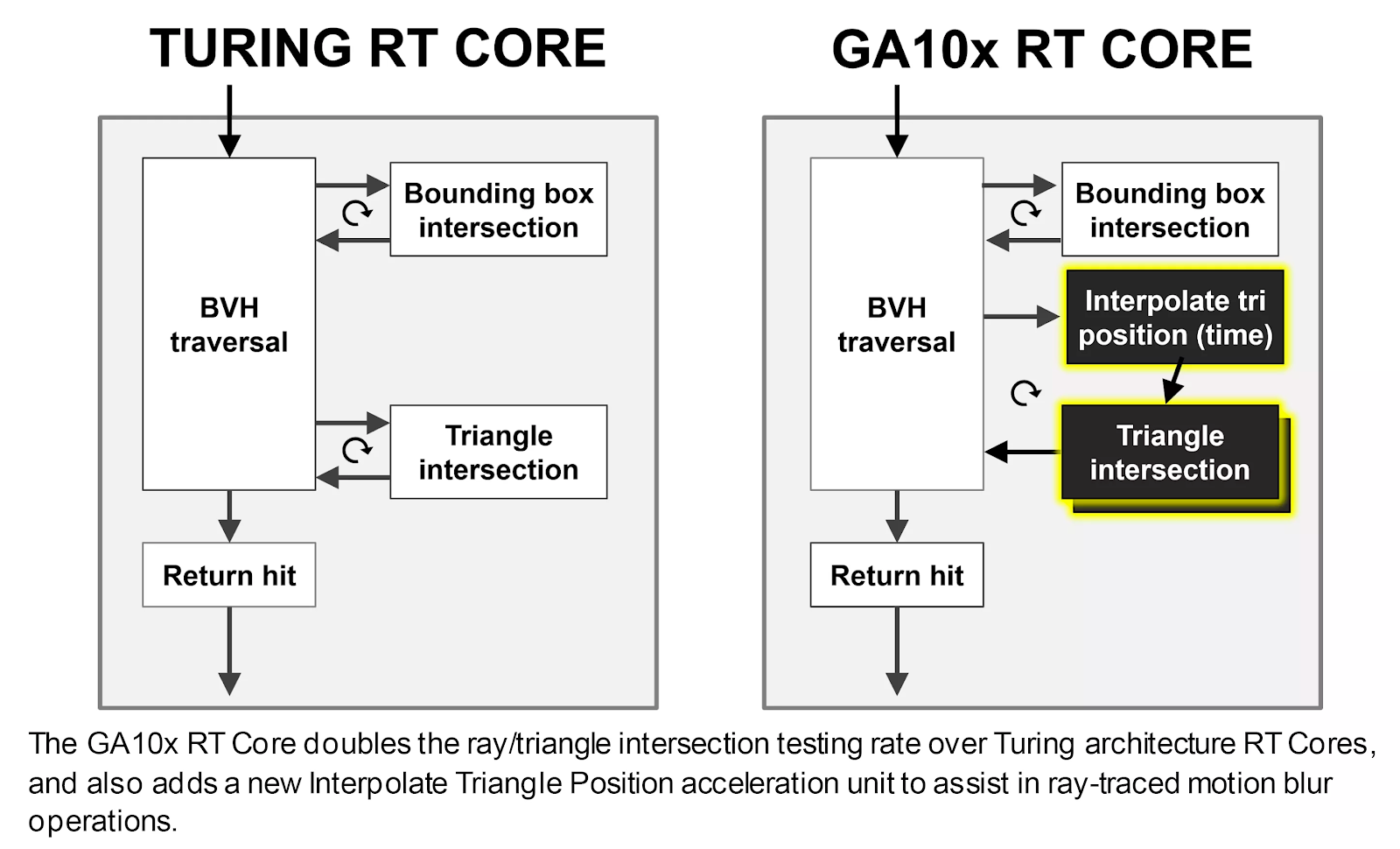

Ядра трассировки лучей также претерпели доработки: теперь они могут работать независимо от ядер CUDA, поэтому, пока они выполняют обход BVH или математику пересечения примитивов лучей, остальная часть SM все еще может обрабатывать шейдеры. Часть ядер трассировки лучей, отвечающая за проверку пересечений, также имеет вдвое большую производительность.

Ядра трассировки лучей также оснащены дополнительным оборудованием, которое помогает применять трассировку лучей к размытию движения, но эта функция в настоящее время доступна только через собственный Optix API от NVIDIA.

Есть и другие хитрости, но в целом подход основан на разумной, но неуклонной эволюции, а не на совершенно новом дизайне. Но учитывая, что в исходных возможностях Turing с самого начала не было ничего особенно плохого, это и неудивительно.

Что же насчет AMD — что они сделали с вычислительными модулями в RDNA 2?

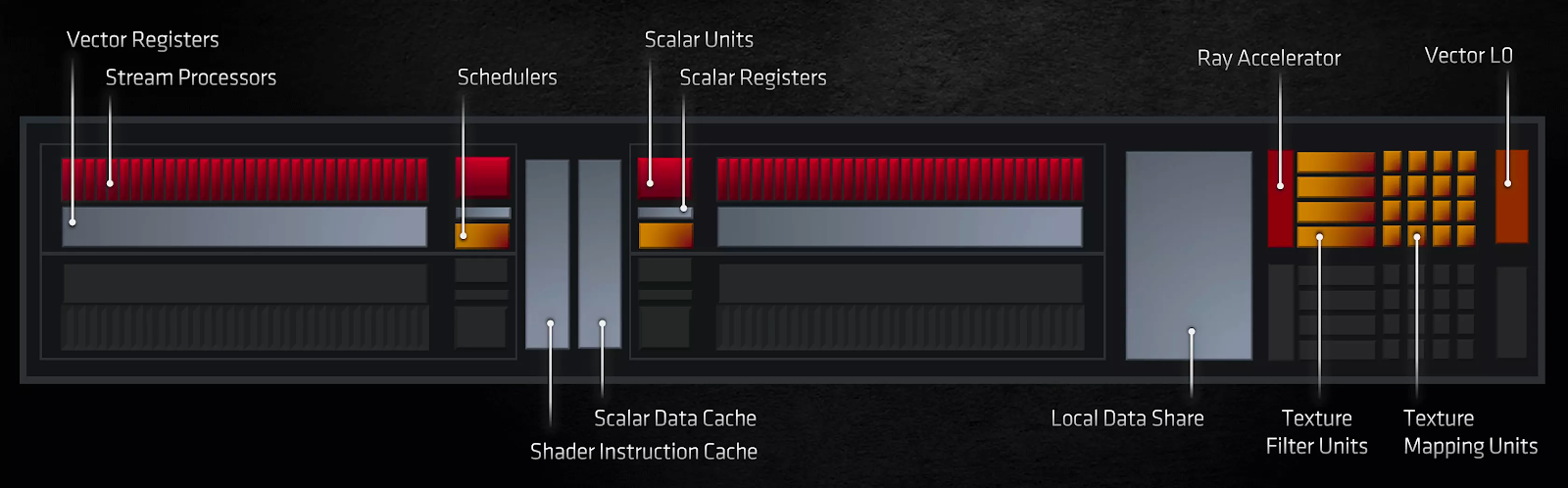

Трассировка лучей по-особенному

На первый взгляд, AMD не сильно изменила вычислительные блоки: они по-прежнему содержат два набора векторных блоков SIMD32, скалярный блок SISD, блоки наложения текстур и стек различных кэшей. Произошли некоторые изменения в отношении того, какие типы данных и связанные с ними математические операции они могут выполнять. Но наиболее заметным изменением для обычного потребителя является то, что AMD теперь предлагает аппаратное ускорение для определенных процедур трассировки лучей.

Эта часть вычислительных блоков выполняет проверки пересечения лучевого бокса или лучевого треугольника — то же самое, что и ядра трассировки лучей в Ampere. Однако последние также ускоряют алгоритмы обхода BVH, тогда как в RDNA 2 это делается с помощью вычислительных шейдеров с использованием модулей SIMD 32.

Независимо от того, сколько у вас шейдерных ядер или насколько высоки их тактовые частоты, использование специализированных схем, предназначенных для выполнения только одной задачи, всегда будет предпочтительнее, чем обобщенный подход. Именно поэтому и были изобретены графические процессоры: все в мире рендеринга можно сделать с помощью ЦП, но общий характер делает их непригодными для графических применений.

Блоки Ray Accelerator находятся рядом с текстурными процессорами, поскольку они фактически являются частью одной и той же структуры. Хотя эта система действительно предлагает большую гибкость и устраняет необходимость в том, чтобы части кристалла занимались только трассировкой лучей и ничем другим одновременно с ней, первая реализация ее имеет некоторые недостатки. Наиболее примечательным из них является то, что текстурные процессоры могут обрабатывать только операции, связанные с текстурами или пересечениями примитивов лучей. Учитывая, что ядра трассировки лучей NVIDIA теперь работают полностью независимо от остальной части SM, это дает Ampere явное преимущество по сравнению с RDNA 2 в проработке структур ускорения и тестах пересечений, необходимых для трассировки лучей.

Пока производительность трассировки лучей в новейших видеокартах AMD была исследована лишь вкратце, но уже заметно, что влияние трассировки лучей очень зависит от игры.

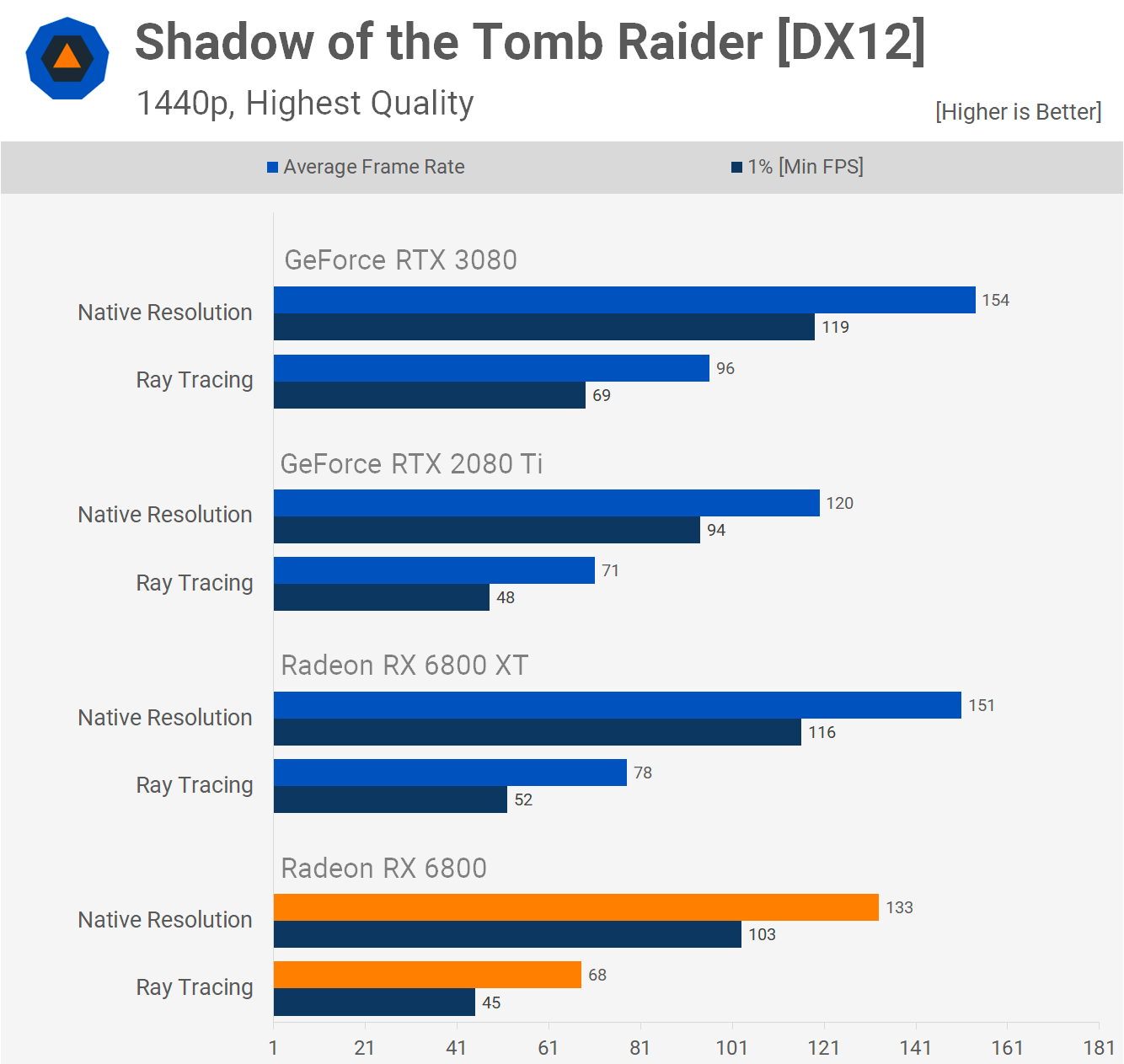

Например, в Gears 5 видеокарта Radeon RX 6800 (в которой используется вариант графического процессора Navi 21 с 60 CU) при включении трассировки лучей снизила частоту кадров только на 17%, тогда как в Shadow of the Tomb Raider — аж на 52%. Для сравнения, у NVIDIA RTX 3080 (с использованием 68 SM GA102) средняя потеря частоты кадров в этих двух играх составила 23% и 40% соответственно.

Чтобы больше рассказать о реализации AMD, необходим более подробный анализ трассировки лучей, однако в качестве первой итерации технологии она кажется вполне конкурентоспособной, но чувствительной к тому, какое приложение выполняет трассировку.

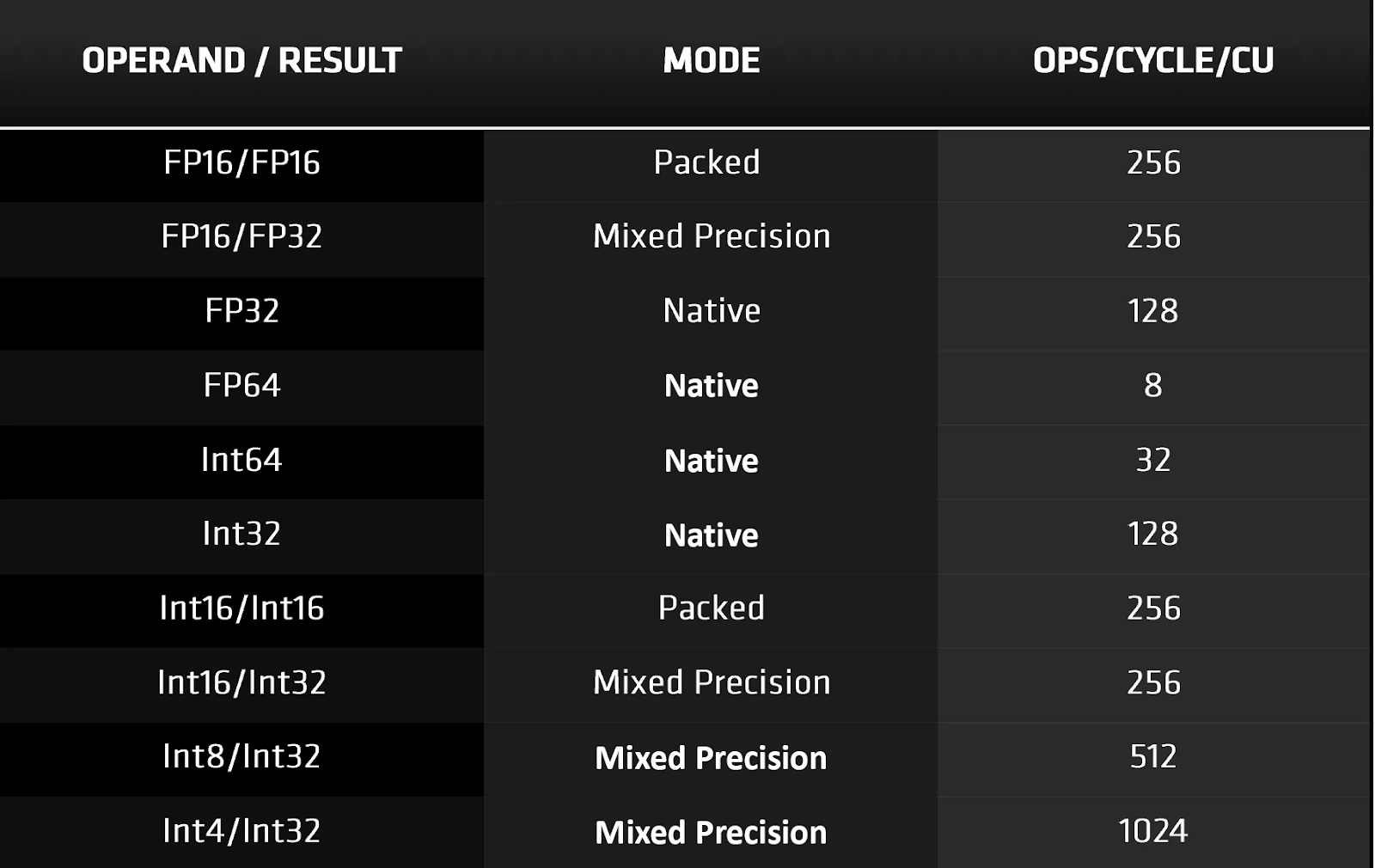

Как упоминалось ранее, вычислительные блоки в RDNA 2 теперь поддерживают больше типов данных: наиболее заметными из них являются типы данных с низкой точностью, такие как INT4 и INT8. Они используются для тензорных операций в алгоритмах машинного обучения, и хотя AMD имеет отдельную архитектуру (CDNA) для ИИ и центров обработки данных, это обновление предназначено для использования с DirectML.

Этот API является недавним дополнением к семейству Microsoft DirectX 12. Комбинация аппаратного и программного обеспечения обеспечивает лучшее ускорение шумоподавления в алгоритмах трассировки лучей и временного масштабирования. В случае с последним у NVIDIA, конечно же, есть своя технология под названием DLSS. Она использует тензорные ядра в SM для выполнения части вычислений — но учитывая, что аналогичный процесс может быть построен и через DirectML, может показаться, что эти компоненты в некоторой степени избыточны. Однако и в Turing, и в Ampere тензорные ядра также обрабатывают все математические операции, связанные с форматами данных FP16.

В RDNA 2 такие вычисления выполняются с использованием шейдерных блоков и упакованных форматов — то есть, каждый 32-битный векторный регистр содержит два 16-битных.

Какой же подход лучше?

AMD преподносит свои блоки SIMD32 как векторные процессоры, поскольку они выдают одну инструкцию для нескольких значений данных. Один векторный блок содержит 32 потоковых процессора, и поскольку каждый из них работает только с одним фрагментом данных, по факту операции носят скалярный характер. По сути, это то же самое, что и SM в Ampere, где каждый блок обработки также применяет одну инструкцию для 32 значений данных.

Но если у NVIDIA весь SM может обрабатывать до 128 вычислений FMA FP32 за цикл , один вычислительный блок RDNA 2 производит только 64 таких вычисления. Использование FP16 увеличивает это значение до 128 FMA за цикл, что совпадает с тем, что делают тензорные ядра в Ampere при стандартных вычислениях FP16.

SM NVIDIA могут выполнять инструкции для одновременной обработки целочисленных значений и значений с плавающей запятой (например, 64 FP32 и 64 INT32) и имеют независимые блоки для операций FP16, тензорной математики и процедур трассировки лучей. Блоки управления AMD выполняют большую часть рабочей нагрузки блоков SIMD32, хотя у них есть отдельные скалярные блоки, которые поддерживают простую целочисленную математику.

Таким образом, может показаться, что у Ampere здесь преимущество: у GA102 больше SM, чем у Navi 21, и у них больше возможностей, когда дело доходит до пиковой пропускной способности, гибкости и предлагаемых функций. Но у AMD есть свой джокер в рукаве.

Система памяти и многоуровневые кэши

Давайте сначала взглянем на Ampere. В целом, внутри произошли некоторые заметные изменения: объем кэша 2-го уровня увеличился на 50% (Turing TU102 имел 4096 КБ, соответственно), а кэши 1-го уровня в каждом SM увеличились вдвое.

Как и раньше, кэш-память L1 здесь настраивается с точки зрения того, сколько места в кэше можно выделить для данных, текстур или общих вычислений. Для графических шейдеров (например, вершинных или пиксельных) и асинхронных вычислений кэш фактически установлен на:

- 64 КБ для данных и текстур;

- 48 КБ для общей памяти;

- 16 КБ для конкретных операций.

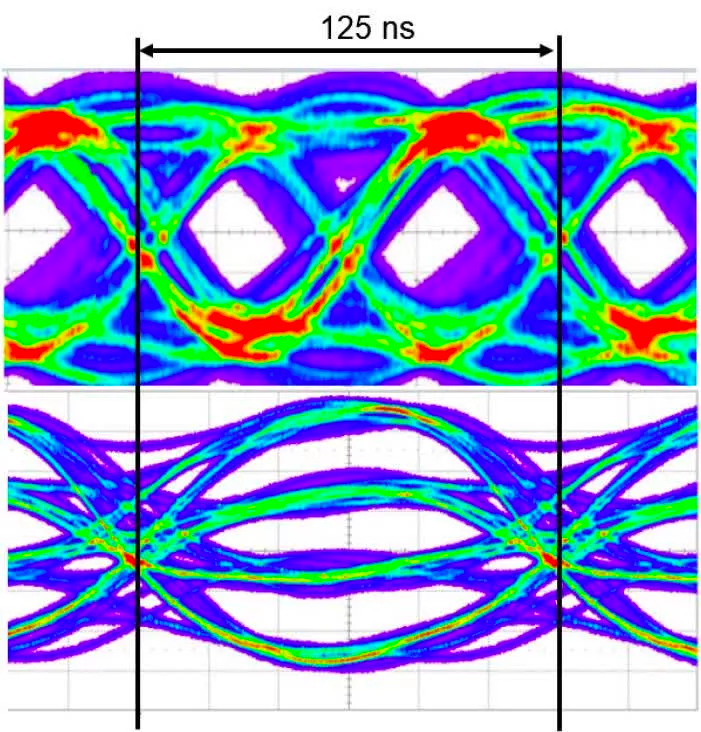

Остальная часть внутренней памяти осталась прежней, но за пределами графического процессора ждет приятный сюрприз. NVIDIA стала работать с Micron и теперь использует модифицированную версию GDDR6 для своих потребностей в локальной памяти. По сути, это тот же GDDR6, но шина данных полностью заменена. Вместо того, чтобы использовать обычную настройку 1 бит на вывод, при которой сигнал очень быстро колеблется между двумя значениями напряжения (PAM), GDDR6X использует четыре значения напряжения:

Благодаря этому GDDR6X эффективно передает 2 бита данных на вывод за цикл, поэтому при той же тактовой частоте и количестве выводов полоса пропускания удваивается. GeForce RTX 3090 поддерживает 24 модуля GDDR6X, работающих в одноканальном режиме и рассчитанных на 19 Гбит/с, что дает пиковую пропускную способность 936 ГБ/с. Это на 52% больше, чем у GeForce RTX 2080 Ti. Таких показателей пропускной способности в прошлом можно было достигнуть только при помощи HBM2, реализация которого может быть куда более дорогостоящей, чем GDDR6.

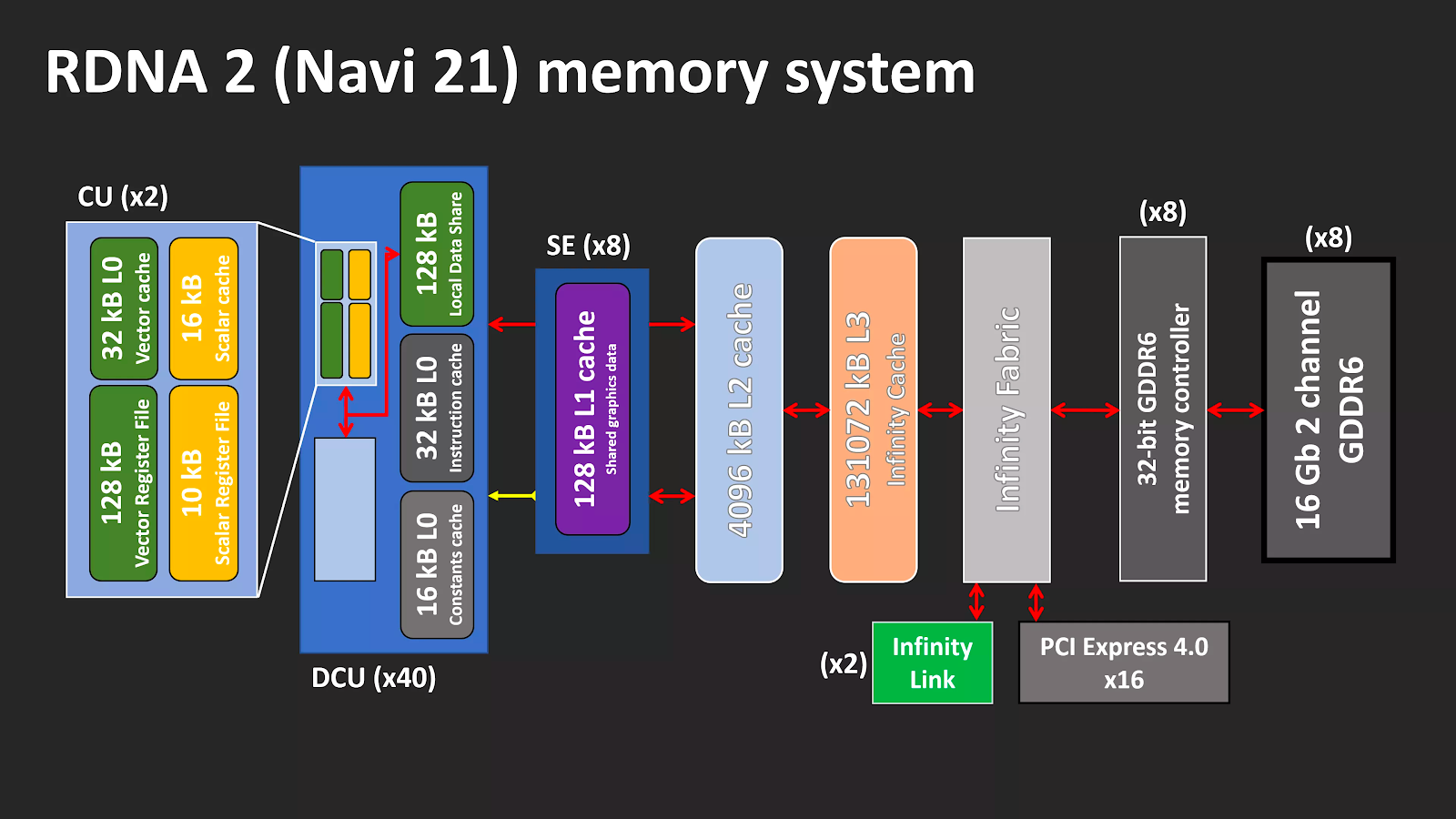

Однако такую память производит только Micron, а использование PAM4 добавляет дополнительной сложности производственному процессу, требуя гораздо более жестких допусков при передаче сигналов. AMD пошла по другому пути: вместо того, чтобы обращаться за помощью к стороннему поставщику, они использовали свое подразделение ЦП, чтобы изобрести что-то новое. Общая система памяти в RDNA 2 не сильно преобразилась по сравнению с предшественницей — но есть два существенных изменения.

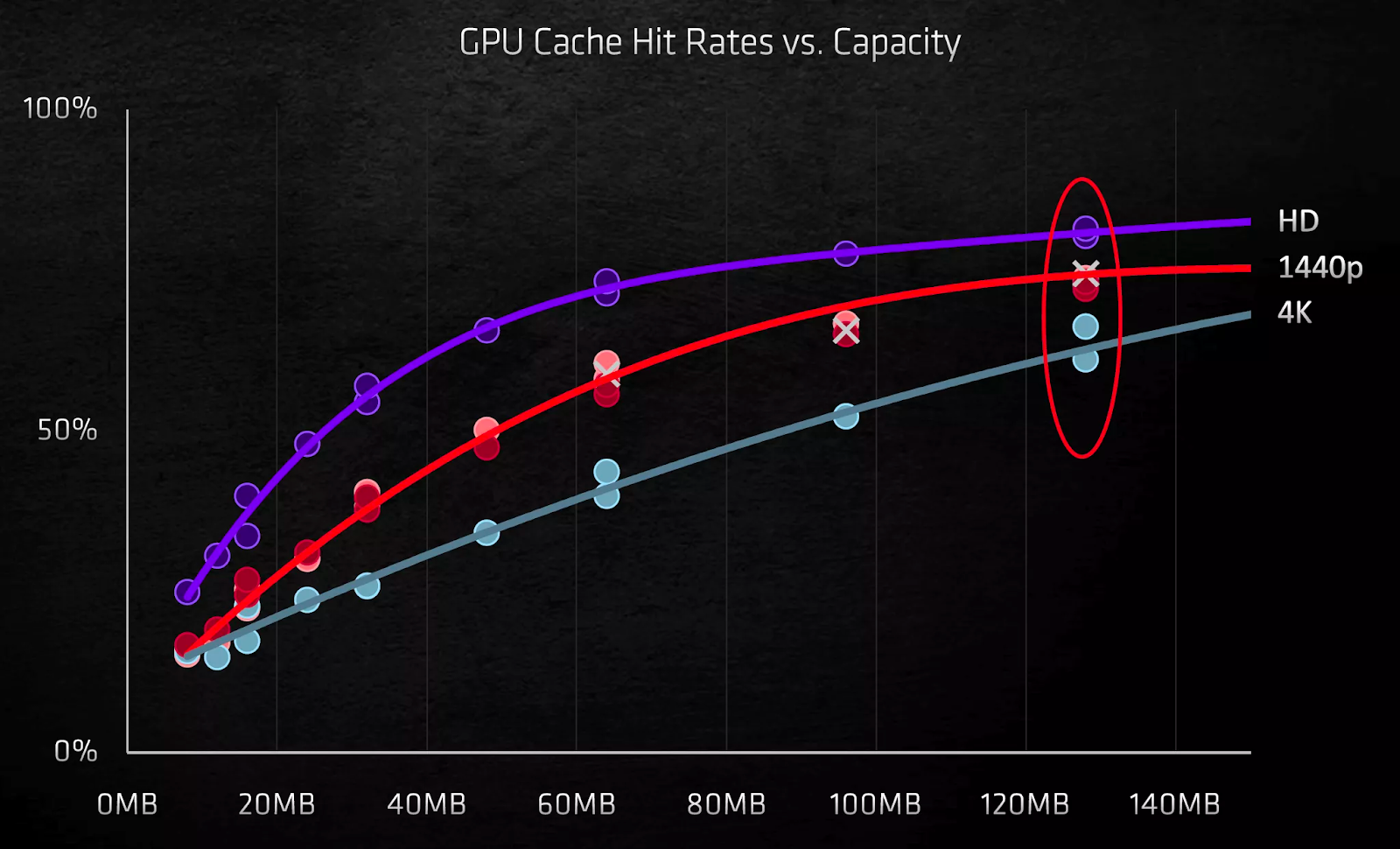

Каждый шейдерный движок теперь имеет два набора кэшей первого уровня. Но как можно втиснуть в графический процессор 128 МБ кэш-памяти третьего уровня? Используя конструкцию SRAM для кэша L3, AMD встроила в чип два набора кэш-памяти высокой плотности объемом 64 МБ. Транзакции данных обрабатываются 16 наборами интерфейсов, каждый из них сдвигает 64 байта за такт.

Так называемый Infinity Cache имеет свой собственный тактовый домен и может работать на частоте 1,94 ГГц, что дает пиковую внутреннюю пропускную способность 1986,6 ГБ/с. И поскольку это не внешняя DRAM, задержки здесь исключительно низкие. Такой кэш идеально подходит для хранения структур ускорения трассировки лучей, и поскольку обход BVH включает в себя множество проверок данных, Infinity Cache должен в этом особенно помочь.

На данный момент не ясно, работает ли кеш третьего уровня в RDNA 2 так же, как в ЦП Zen 2: то есть, как кэш жертвы (victim cache) второго уровня. Обычно, когда необходимо очистить последний уровень кэша, чтобы освободить место для новых данных, любые новые запросы этой информации должны поступать в DRAM.

В кэше жертвы хранятся данные, помеченные для удаления из следующего уровня памяти, и имея под рукой 128 МБ, Infinity Cache потенциально может хранить 32 полных набора кэша L2. Эта система снижает нагрузку на контроллеры GDDR6 и DRAM.

Старые конструкции графических процессоров AMD боролись с нехваткой внутренней пропускной способности — особенно после увеличения тактовой частоты, — но дополнительный кэш во многом поможет при решении этой проблемы.

Так что же лучше?

Использование GDDR6X дает GA102 огромную полосу пропускания для локальной памяти, а большие кэши помогают уменьшить влияние промахов кэша. Массивная кэш-память 3-го уровня Navi 21 позволяет реже использовать DRAM, при этом графический процессор может работать на более высоких тактовых частотах без дефицита данных.

Решение AMD придерживаться GDDR6 означает, что сторонним поставщикам доступно больше источников памяти, в то время как любая компания, производящая GeForce RTX 3080 или 3090, будет вынуждена использовать Micron. И хотя GDDR6 поставляется с модулями различной плотности, GDDR6X в настоящее время ограничен 8 Гб.

Система кэширования в RDNA 2, возможно, является лучшим подходом, чем та, что используется в Ampere, поскольку использование нескольких уровней встроенной SRAM всегда обеспечивает более низкие задержки и лучшую производительность для заданного диапазона мощности, чем внешняя DRAM, независимо от пропускной способности последней.

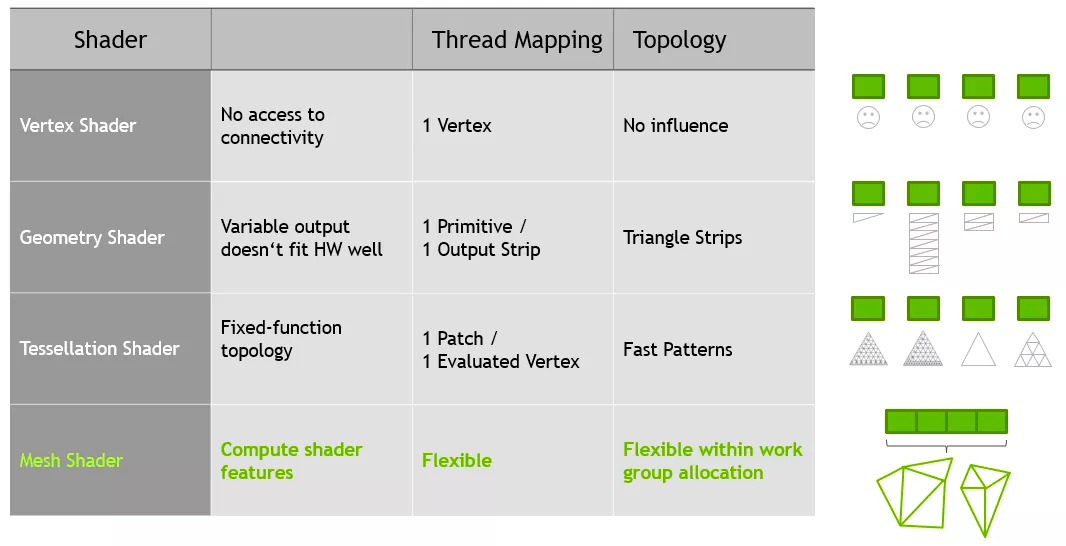

Пайплайны рендеринга

Обе архитектуры содержат множество обновлений для фронтэнда и бэкэнда пайплайнов рендеринга. Ampere и RDNA 2 полностью поддерживают mesh-шейдеры и variable rate-шейдеры в DirectX12 Ultimate, хотя чип NVIDIA обладает большей геометрической производительностью благодаря большему количеству процессоров для этих задач.

Хотя использование mesh-шейдеров позволит разработчикам создавать еще более реалистичное окружение, ни в одной игре никогда не будет полной привязки производительности к этому этапу процесса рендеринга. Это связано с тем, что основная часть самой сложной работы приходится на этапы трассировки пикселей или лучей.

Именно здесь вступает в игру использование variable rate-шейдеров. В основном этот процесс включает применение шейдеров для освещения и цвета на блоке пикселей, а не на отдельных пикселях. Это похоже на уменьшение разрешения игры для повышения производительности, но, поскольку его можно применить только к выбранным областям, потеря визуального качества не всегда очевидна.

Обе архитектуры также получили обновление для блоков вывода рендеринга (ROP), поскольку это улучшит производительность при высоких разрешениях независимо от того, используются ли variable rate-шейдеры. Во всех предыдущих поколениях своих графических процессоров NVIDIA привязывала ROP к контроллерам памяти и кэшу 2-го уровня.

В Turing восемь блоков ROP были напрямую связаны с одним контроллером и фрагментом кэша размером 512 КБ. Добавление большего количества ROP представляется проблематичным, поскольку для этого требуется больше контроллеров и кэша, поэтому для Ampere ROP теперь полностью выделены для GPC. GA102 поддерживает 12 ROP на один GPC (каждый обрабатывает 1 пиксель за такт), что дает в общей сложности 112 блоков для всего чипа.

AMD следует системе, аналогичной старому подходу NVIDIA (т. е. привязке к контроллеру памяти и кэш-памяти L2), хотя их ROP в основном используют кэш первого уровня для чтения/записи и смешивания пикселей. В чипе Navi 21 ROP теперь обрабатывает 8 пикселей за цикл в 32-битном цвете и 4 пикселя в 64-битном.

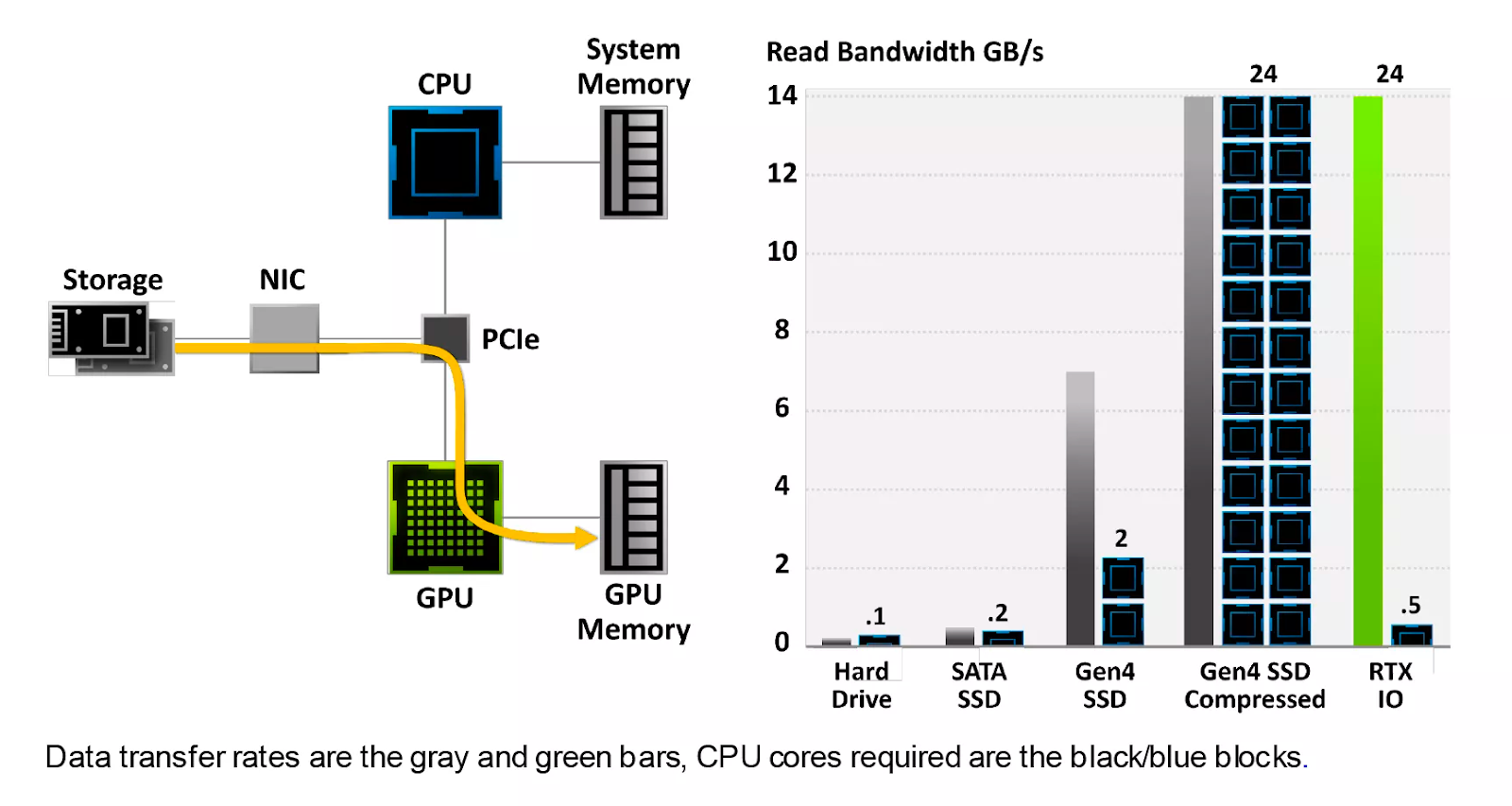

RTX IO в NVIDIA — система обработки данных, которая позволяет графическому процессору напрямую обращаться к накопителю, копировать необходимые данные, а затем распаковывать их с помощью ядер CUDA.

Современные методы предполагают, что всем этим управляет центральный процессор: он получает запрос данных от драйверов графического процессора, копирует данные с накопителя в системную память, распаковывает их, а затем копирует в DRAM графической карты.

Этот механизм по своей природе является последовательным: ЦП обрабатывает один запрос за раз. NVIDIA заявляет о таких цифрах, как «100-кратная пропускная способность» и «20-кратное снижение нагрузки на ЦП», но до тех пор, пока система не будет протестирована в реальных условиях, их никак нельзя будет исследовать дальше.

Когда AMD представила RDNA 2 и новые видеокарты Radeon RX 6000, вместе с ними была представлена и так называемая Smart Access Memory. Это не ответ на RTX IO — на самом деле, это даже не новая функция. По умолчанию контроллер PCI Express в ЦП может адресовать до 256 МБ памяти видеокарты для каждого отдельного запроса доступа. Это значение устанавливается размером регистра базового адреса (BAR), и еще в 2008 году в спецификации PCI Express 2.0 была дополнительная функция, позволяющая изменять его размер. Преимущество его состоит в том, что нет нужды обрабатывать большое количество запросов на доступ, чтобы адресовать всю DRAM карты.

Функция требует поддержки операционной системой, центральным процессором, материнской платой, графическим процессором и его драйверами. В настоящее время на ПК с Windows система ограничена определенной комбинацией процессоров Ryzen 5000, материнских плат серии 500 и видеокарт Radeon RX 6000.

Эта простая функция дала поразительные результаты на тестах: повышение производительности на 15% при разрешении 4K. Неудивительно, что вскоре NVIDIA заявила, что реализует эту функцию для RTX 3000 в ближайшем будущем.

Мультимедиа-движок и видеовыход

Обе архитектуры обеспечивают вывод изображения через HDMI 2.1 и DisplayPort 1.4a. Первый предлагает более широкую полосу пропускания сигнала, но оба они рассчитаны на 4K при 240 Гц с HDR и 8K при 60 Гц. Это достигается при помощи либо цветовой субдискретизации 4:2:0, либо DSC 1.2a. Это алгоритмы сжатия видеосигнала, обеспечивающие значительное снижение требований к полосе пропускания без большой потери визуального качества. Без них даже пиковой пропускной способности HDMI 2.1 в 6 ГБ/с было бы недостаточно для передачи изображений 4K с частотой 60 Гц.

Ampere и RDNA 2 также поддерживают системы с переменной частотой обновления (FreeSync для AMD, G-Sync для NVIDIA), в кодировании и декодировании видеосигналов между ними также нет заметной разницы.

Независимо от того, какой процессор рассматривать, в обоих есть поддержка декодирования 8K AV1, 4K H.264 и 8K H.265, хотя и еще не было тщательно изучено, насколько хорошо они оба работают в таких ситуациях. Ни одна из компаний не раскрывает подробностей о внутреннем устройстве в этих областях. Какими бы важными они ни были в наши дни, все внимание по-прежнему привлекают другие аспекты графических процессоров.

Созданы для вычислений, созданы для игр

Раньше AMD и NVIDIA использовали разные подходы к выбору архитектуры и конфигурации. Но по мере того, как 3D-графика набирала все большую популярность, они становились все более похожими.

На данный момент у NVIDIA есть три чипа, использующих технологию Ampere: GA100, GA102 и GA104.

Последний — урезанная версия GA102. GA100 — совсем другое дело.

В нем нет ядер трассировки лучей и CUDA с поддержкой INT32+FP32 — вместо этого он содержит множество дополнительных модулей FP64, еще больше load/store систем и огромный объем кэш-памяти L1/L2. Все это объясняется тем, что он разработан для вычислений ИИ и анализа данных.

GA102/104, в свою очередь, должны охватывать все остальные рынки, на которые нацелена NVIDIA: геймеров, профессиональных графических художников и инженеров, а также маломасштабный ИИ и вычислительные системы. Ampere должен быть мастером на все руки — а это задача не из легких.

RDNA 2 была разработана только для игр на ПК и консолях, хотя могла с таким же успехом работать в тех же областях, что и Ampere. Однако AMD решила сохранить свою архитектуру GCN и обновить ее в соответствии с требованиями сегодняшних клиентов.

Там, где RDNA 2 породила Big Navi, можно сказать, что CDNA породила Big Vega: в Instinct MI100 находится их чип Arcturus — 50-миллиардный транзисторный графический процессор с 128 вычислительными блоками.

Хотя NVIDIA в значительной степени доминирует на профессиональном рынке с моделями Quadro и Tesla, Navi 21 просто не нацелена на конкуренцию с ними. Ограничивает ли это каким-либо образом требование, чтобы Ampere вписалась на несколько рынков?

Правильный ответ: нет.

Скоро AMD выпустит Radeon RX 6900 XT, в котором используется полная версия Navi 21 (без отключенных CU), которая сможет работать так же хорошо, как GeForce RTX 3090 или даже лучше. Но GA102 на этой карте также не полностью включен, поэтому у NVIDIA всегда есть возможность обновить эту модель до «супер»-версии, как они это сделали с Turing в прошлом году.

Можно утверждать, что, поскольку RDNA 2 используется в Xbox Series X/S и PlayStation 5, разработчики игр будут отдавать предпочтение этой архитектуре для своих игровых движков. Но стоит просто вспомнить времена, когда GCN использовался в Xbox One и PlayStation 4, чтобы получить представление, как это, вероятно, будет происходить.

Первая версия, выпущенная в 2013 году, использовала графический процессор, построенный на архитектуре GCN 1.0, не появлявшийся в видеокартах для настольных ПК вплоть до следующего года. Xbox One X, выпущенный в 2017 году, использовал GCN 2.0, которому к тому времени было уже более 3 лет.

Так что же — все игры, созданные для Xbox One или PS4, а затем портированные на ПК, по умолчанию лучше работали на видеокартах AMD? А вот и нет. Поэтому мы не можем предположить, что на этот раз с RDNA 2 все будет иначе, несмотря на впечатляющий набор функций.

Но все это в конечном итоге не имеет значения, поскольку оба графических процессора обладают исключительными возможностями и представляют собой чудо того, что может быть достигнуто в производстве полупроводников. NVIDIA и AMD предлагают разные инструменты, поскольку пытаются решать разные проблемы: Ampere стремится быть всем для всех, RDNA 2 — только для игр.

На этот раз битва зашла в тупик, хотя каждый может претендовать на победу в определенной области. Войны ГП еще продолжатся в течение следующего года, когда в бой вступит новый участник: Intel со своей серией Xe. По крайней мере, нам не придется ждать еще два года, чтобы увидеть, как протекает эта борьба.

- Блог компании Pixonic

- Разработка игр

- Компьютерное железо

- Процессоры

Источник https://ocomp.info/igru-na-diskretnoy-videokarte.html

Источник https://tv-st.ru/ustrojstva/odnovremennaya-rabota-vstroennoj-i-vneshnej-videokarty.html

Источник https://habr.com/ru/companies/pixonic/articles/545676/